您的位置:上海毫米网络优化公司 > 网站优化分享 >

相关推荐recommended

- MySQL三表联合查询语法

- 【python】flask结合SQLAlchemy,在视图函数中实现对

- Java校园失物招领系统设计与实现(Idea+Springboot+m

- 【Linux】使用Jenkins + svn + springboot

- VMware虚拟机桥接、NAT、仅主机三种网络模式的配置详解

- 2023 最新版IntelliJ IDEA 2023.1创建Java

- RocketMQ与Kafka架构深度对比

- 用Python手把手教你实现一个爬虫(含前端界面)

- Hive 排名函数ROW

- Idea 反编译jar包

- SpringBoot Maven 项目打包的艺术--主清单属性缺失与N

- nginx-图片模块

- 头歌实践教学平台数据库原理与应用实训答案

- 高校心理教育辅导系统|基于Springboot的高校心理教育辅导系统设

- Llama2模型本地部署(Mac M1 16G)

- 【大数据】大数据概论与Hadoop

- com.mysql.cj.exceptions.CJCommunica

- IntelliJ IDEA 编辑器的全局搜索中使用正则表达式

- 豆瓣9.7,这部Java神作第3版重磅上市!

- SpringCloudGateway之统一鉴权篇

- 十五分钟带你学会 Electron

- Idea Spring Initializr没有 Java 8选项解决

- 基于chow算法的5G超密集网络功率分配matlab仿真

- AI时代的Web开发:让Web开发更轻松

- 关于AI与资本市场的一些思考

- 「PHP系列」PHP 多维数组详解

- 查看mysql 或SQL server 的连接数,mysql超时、最大

- JVM垃圾回收(GC)

- 【排序】排序这样写才对Ⅰ --插入排序与选择排序

- 如何借助Idea创建多模块的SpringBoot项目

Hadoop3.X集群安装

作者:mmseoamin日期:2024-02-04

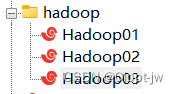

| 服务器 | 运行角色 |

| hadoop01 | namenode、datanode、resourcemanager、nodemanager |

| hadoop02 | secondarynamenode、datanode、nodemanager |

| hadoop03 | datanode、nodemanager |

基础环境准备

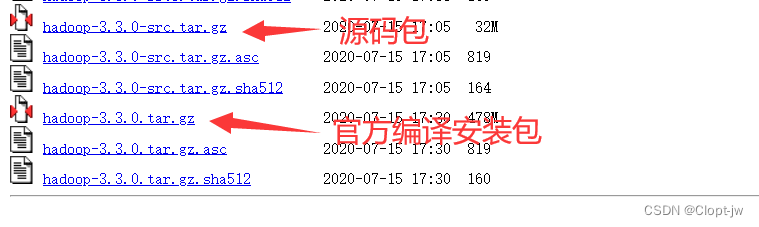

安装包、源码包下载

https://archive.apache.org/dist/hadoop/common/hadoop-3.3.0/

准备三台主机

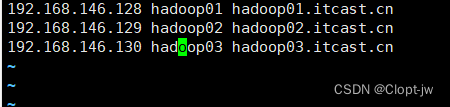

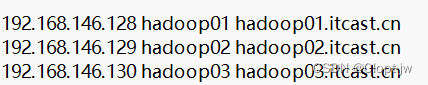

hosts映射

vi /etc/hosts

JDK1.8安装

JDK1.8

配置ssh免密登录

ssh免密登录

上传安装包、解压安装包

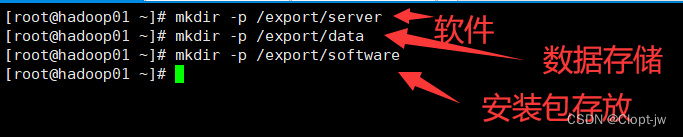

创建工作目录(三台)

上传、解压安装包(hadoop01)

上传到software目录下

#解压 tar zxvf hadoopXXX.tar.gz -C /export/server/

配置hadoop系统环境变量

输入命令:

vi /etc/profile #添加以下内容 export HADOOP_HOME=/usr/software/hadoop-3.3.0 export PATH=$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

保存退出,刷新环境变量

source /etc/profile

hadoop安装包目录结构

| 目录 | 说明 |

| bin | Hadoop最基本的管理脚本和使用脚本的目录,这些脚本是sbin目录下管理脚本的基础实现,用户可以直接使用这些脚本管理和使用Hadoop。 |

| etc | Hadoop配置文件所在的目录 |

| include | 对外提供的编程库头文件(具体动态库和静态库在lib目录中),这些头文件均是用C++定义的,通常用于C++程序访问HDFS或者编写MapReduce程序。 |

| lib | 该目录包含了Hadoop对外提供的编程动态库和静态库,与include目录中的头文件结合使用。 |

| sbin | Hadoop各个模块编译后的jar包所在的目录。 |

| share | Hadoop各个模块编译后的jar包所在的目录。 |

配置hadoop集群主要的配置文件进行配置

| 功能描述 | |

| hadoop-env.sh | 配置Hadoop运行所需的环境变量 |

| yarn-env.sh | 配置Yarn运行所需的环境变量 |

| core-site.xml | Hadoop核心全局配置文件,可在其他配置文件中引用 |

| hdfs-site.xml | HDFS配置文件,继承core-site.xml配置文件 |

| mapred-site.xml | MapReduce配置文件,继承core-site.xml配置文件 |

| yarn-site.xml | Yarn配置文件,继承core-site.xml配置文件 |

编辑hadoop配置文件

hadoop-env.sh

cd /export/server/hadoop-3.3.0/etc/hadoop/ vi hadoop-env.sh

添加以下内容

#配置JAVA_HOME export JAVA_HOME=/usr/software/jdk1.8.0_241 #设置用户以执行对应角色shell命令 export HDFS_NAMENODE_USER=root export HDFS_DATANODE_USER=root export HDFS_SECONDARYNAMENODE_USER=root export TARN_RESOURCEMANAGER_USER=root export TARN_NODEMANAGER_USER=root

yarn-site.xml,添加以下内容

yarn.resourcemanager.hostname hadoop01.itcast.cn yarn,nodemanager.aux-services mapreduce_shuffle yarn.scheduler.minimum-allocation-mb 512 yarn.scheduler.maximum-allocation-mb 2048 yarn.nodemanager.vmem-pmem-ratio 4

core-site.xml,添加以下内容

#hdfs文件系统访问地址 #hadoop本地数据存储目录 format是自动生成 fs.defaultFS hdfs://hadoop01.itcast.cn:8020 #在Web UI访问HDFS使用的用户名 hadoop.tmp.dir /export/data/hadoop hadoop.http.staticuser.user root

hdfs-site.xml,添加以下内容

dfs.namenode.secondary.http-address hadoop02.itcast.cn:9868

mapred-site.xml,添加以下内容

mapreduce.framework.name yarn yarn.app.mapreduce.am.env HADOOP_MAPRED_HOME=${HADOOP_HOME} mapreduce.reduce.env HADOOP_MAPRED_HOME=${HADOOP_HOME}

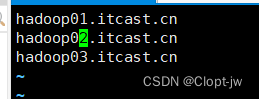

vi workers,添加以下内容

hadoop01.itcast.cn hadoop02.itcast.cn hadoop03.itcast.cn

分发安装包scp同步到其他机器

cd /export/server/ scp -r hadoop-3.3.0 root@hadoop02:/export/server/ scp -r hadoop-3.3.0 root@hadoop03:/export/server/

NameNode format 初始化操作

首次启动HDFS时,必须对其进行初始化操作

format本质上是对HDFS进行清理和准备工作

命令:hdfs namenode -format

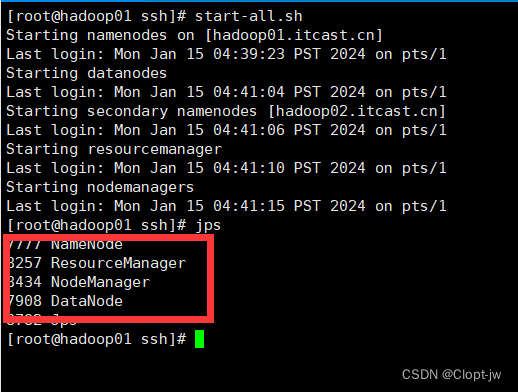

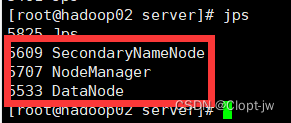

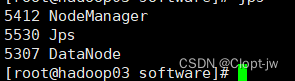

hadoop启动和关闭

每次手动启动关闭一个进程

HDFS集群:

hdfs --daemon start namenode | datanode | secondarynamenode

hdfs --daemon stop namenode | datanode | secondarynamenode

YARN集群:

yarn --daemon start resourcemanager | nodemanager

yarn --daemon stop resourcemanager | nodemanager

start-all.sh

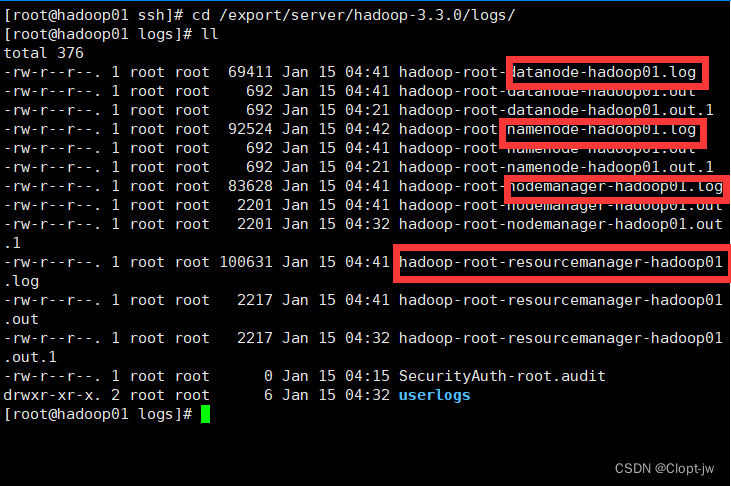

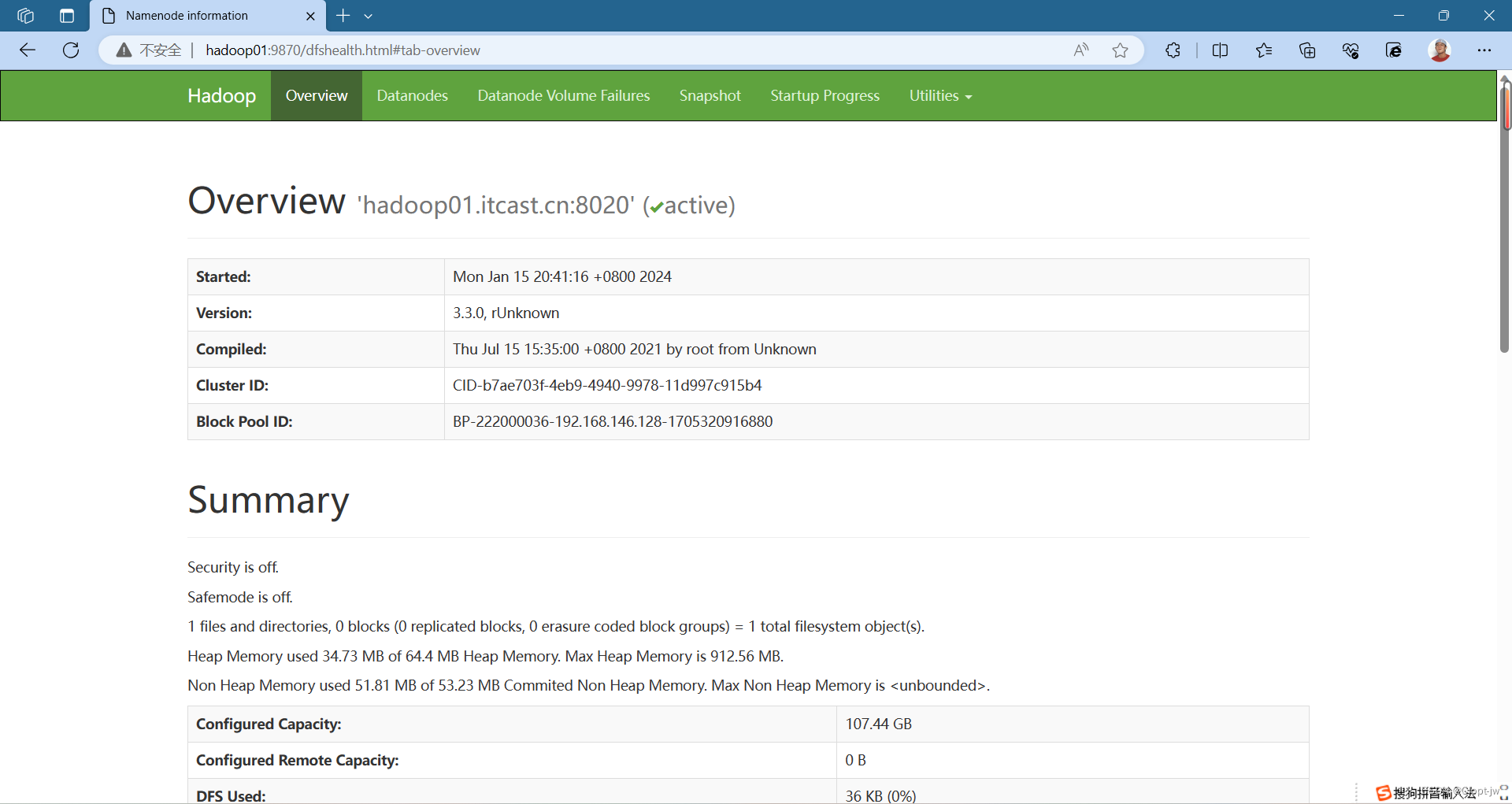

安装成功

或者看日志查看是否安装成功

在Windows中配置hosts

C:\Windows\System32\drivers\etc

上一篇:HIve安装配置(超详细)