- SpringBoot使用WebSocket

- 2024年(第十届)全国大学生统计建模大赛选题参考(一)

- SpringBoot 整合Swagger2

- Springboot之自定义注解

- 二刷大数据(一)- Hadoop

- Python某城市酒店爬虫数据可视化分析和推荐查询系统

- 解决使用Springboot jpa update数据时报错Execu

- 全国主要城市建筑轮廓(含层高)矢量数据分享及最新AI提取建筑分布方法介

- Linux系统部署SQL Server结合内网穿透实现公网访问本地数据

- Nginx使用教程

- fabricjs控制背景图和画布图片展示

- 【MySQL】——用户和权限管理(一)

- Hive和MySQL的部署、配置Hive元数据存储到MySQL、Hiv

- SpringBoot整合Druid数据库连接池&多数据源&am

- IDEA 2024 配置 Maven 创建 Spring Boot 项

- SpringBoot(java)实现websocket实现实时通信

- 革新鞋服零售:数据驱动的智能商品管理 解锁库存优化与高效增长

- Spring Boot集成百度UidGenerator雪花算法使用以及

- 浅谈Java JVM

- 云计算的大数据处理:实时分析与批处理

- SQL之CASE WHEN用法详解

- lua学习笔记20(lua中一些自带库的学习)

- [架构之路-226]:信息系统建模 - 实体关系图、数据流图、数据字典

- 使用Node.js搭建服务器

- 基于jsp+jdbc+mysql+html+css网上珠宝购物商城系统

- 毕业设计——基于网络爬虫的电影数据可视化分析系统的设计与实现(综述+爬

- 【MyBatis Plus】初识 MyBatis Plus,在 Spr

- PTA L1-064 估值一亿的AI核心代码,详解+每一个测试点的分析

- org.springframework.beans.factory.U

- 头歌实践教学平台数据库原理与应用实训答案

目前flink中的资源管理主要是使用的hadoop圈里的yarn,故此需要先搭建hadoop环境并启动yarn和hdfs,由于看到的教程都是集群版,现实是只有1台机器,故此都是使用这台机器安装。

1.下载对应hadoop安装包

https://dlcdn.apache.org/hadoop/common/hadoop-3.3.5/hadoop-3.3.5.tar.gz

2.解压到指定路径比如这里我选择的如下:

3.修改hadoop相关配置

3.修改hadoop相关配置

cd /root/dxy/hadoop/hadoop-3.3.5/etc/hadoop

vi core-site.xml 核心配置文件

fs.defaultFS hdfs://10.26.141.203:8020 hadoop.tmp.dir /root/dxy/hadoop/hadoop-3.3.5/datas hadoop.http.staticuser.user root

vi hdfs-site.xml 修改hdfs配置文件

dfs.namenode.http-address 10.26.141.203:9870 dfs.namenode.secondary.http-address 10.26.141.203:9868

vi yarn-site.xml 修改yarn配置

~ yarn.nodemanager.aux-services mapreduce_shuffle yarn.resourcemanager.hostname 10.26.141.203 yarn.nodemanager.env-whitelist JAVA_HOME,HADOOP_COMMON_HOME,HADOOP_HDFS_HOME,HADOOP_CONF_DIR,CLASSPATH_PREPEND_DISTCACHE,HADOOP_YARN_HOME,HADOOP_MAPRED_HOME

vim mapred-site.xml

mapreduce.framework.name yarn

vi workers 填上 服务器ip 如:

10.26.141.203

修改环境变量:

export HADOOP_HOME=/root/dxy/hadoop/hadoop-3.3.5

export PATH=$PATH:$HADOOP_HOME/bin

export PATH=$PATH:$HADOOP_HOME/sbin

export HADOOP_CONF_DIR=${HADOOP_HOME}/etc/hadoop

export HADOOP_CLASSPATH=`hadoop classpath`

source /etc/profile

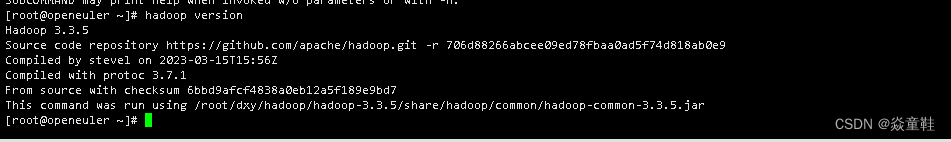

完成后可以执行hadoop version 查看是否配置成功如下:

hdfs第一次启动时需要格式化

hdfs namenode -format

启动yarn和hdfs

sbin/start-dfs.sh

sbin/start-yarn.sh

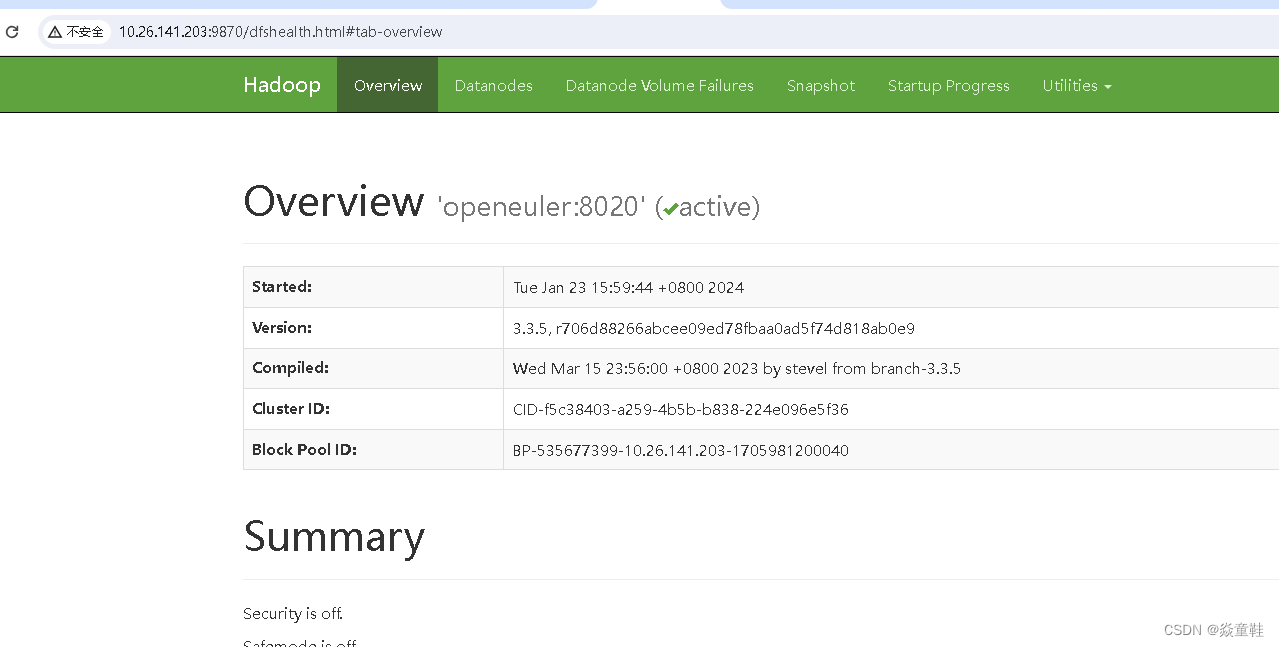

使用界面访问是否启动成功:

使用application运行flink任务并提交到yarn上如下:

bin/flink run-application -t yarn-application -c com.dxy.learn.demo.SocketStreamWordCount FlinkLearn-1.0-SNAPSHOT.jar

上一篇:简单试验:用Excel进行爬虫