- mysql如何自定义自增主键值,以及所遇到的不生效问题

- MySQL解决count查询慢而写的分页查询总量缓存器

- PostgreSQL的date

- SQL Server 数据表模糊查询(like 用法)以及查询函数

- “AI 程序员”席卷而来,吴恩达四步设计让 Agent 提前超越 GP

- Spring AOP(1)

- SQL拆分字段内容(含分隔符)

- The artifact mysql:mysql-connector-

- 刷题之Leetcode24题(超级详细)

- 【Linux】环境下部署Nginx服务 - 二进制部署方式

- 探索设计模式的魅力:开启智慧之旅,AI与机器学习驱动的微服务设计模式探

- 大数据 DataX-Web 详细安装教程

- SpringBoot 使用【AOP 切面+注解】实现在请求调用 Con

- Windows 安装配置 RabbitMQ 详解

- SpringMVC基础篇(二)

- 【机器人小车】自己动手用ESP32手搓一个智能机器人:ESP32-CA

- tomcat默认最大线程数、等待队列长度、连接超时时间

- 5.118 BCC工具之xfsslower.py解读

- Java Spring Boot 写 API 接口

- 【SQL Server】超详细SQLServer日期转换、字符串、数学

- 基于Django闲置物品二手物品交易平台系统设计与实现(Pycharm

- 【AI云原生】Kubernetes容器环境下大模型训练和推理的关键技术

- Rust面试宝典第6题:快乐数

- 前馈神经网络解密:深入理解人工智能的基石

- Springboot利用CompletableFuture异步执行线程

- 019——IIC模块驱动开发(基于EEPROM【AT24C02】和I.

- 【自媒体创作利器】AI白日梦+ChatGPT 三分钟生成爆款短视频

- 每日五道java面试题之spring篇(六)

- 开源浏览器Firefox:使用Docker本地部署并远程访问进行测试

- Spring-Kafka 3.0 消费者消费失败处理方案

文章目录

- 高并发带来的问题

- 编写代码

- 修改配置

- 压力测试

- 修改配置,并启动软件

- 添加线程组

- 配置线程并发数

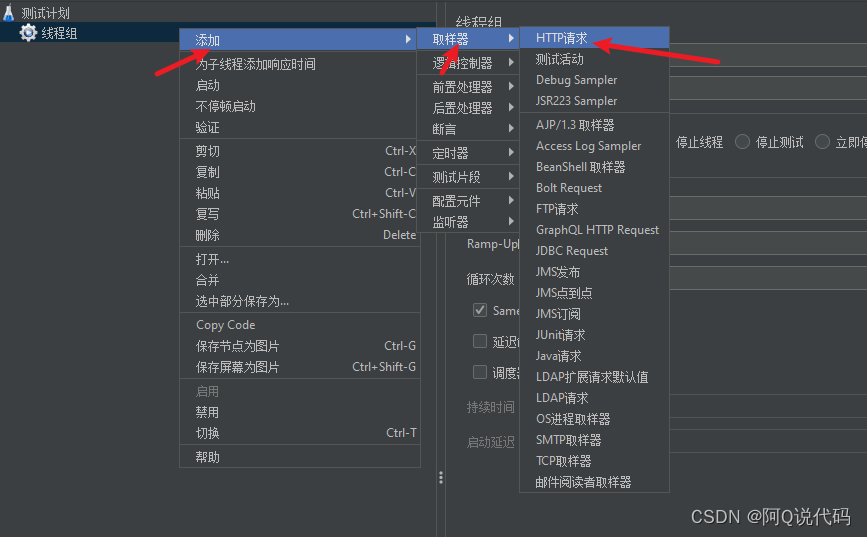

- 添加Http取样

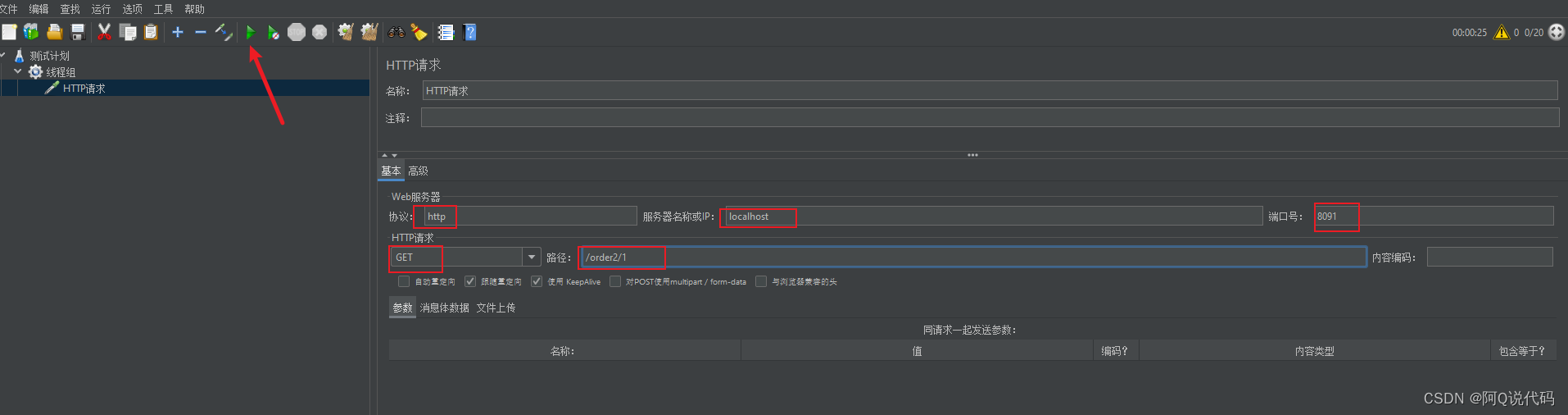

- 配置取样,并启动测试

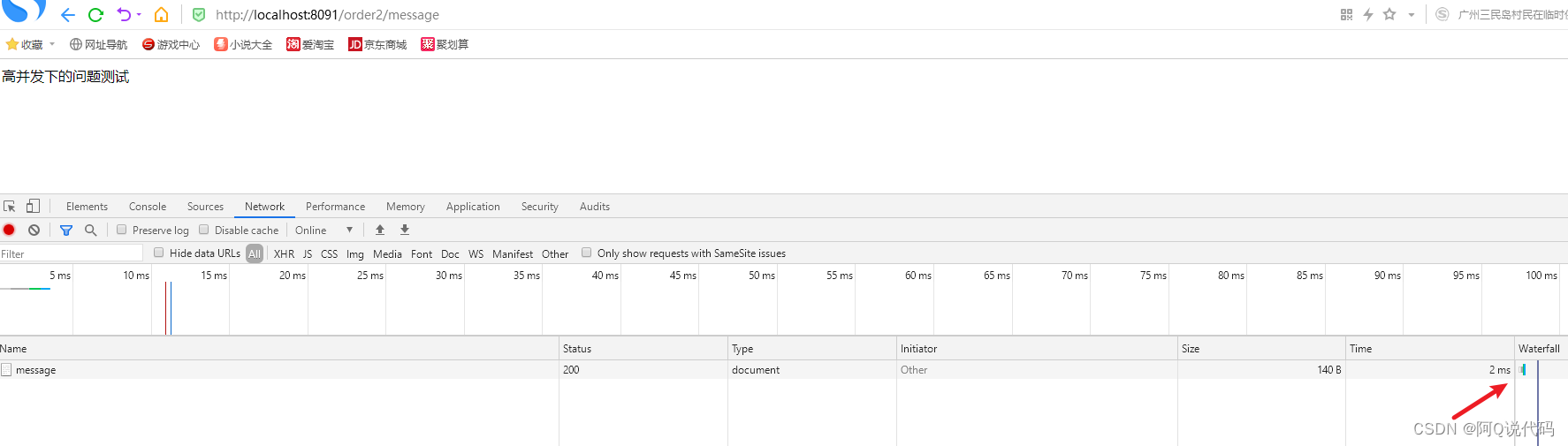

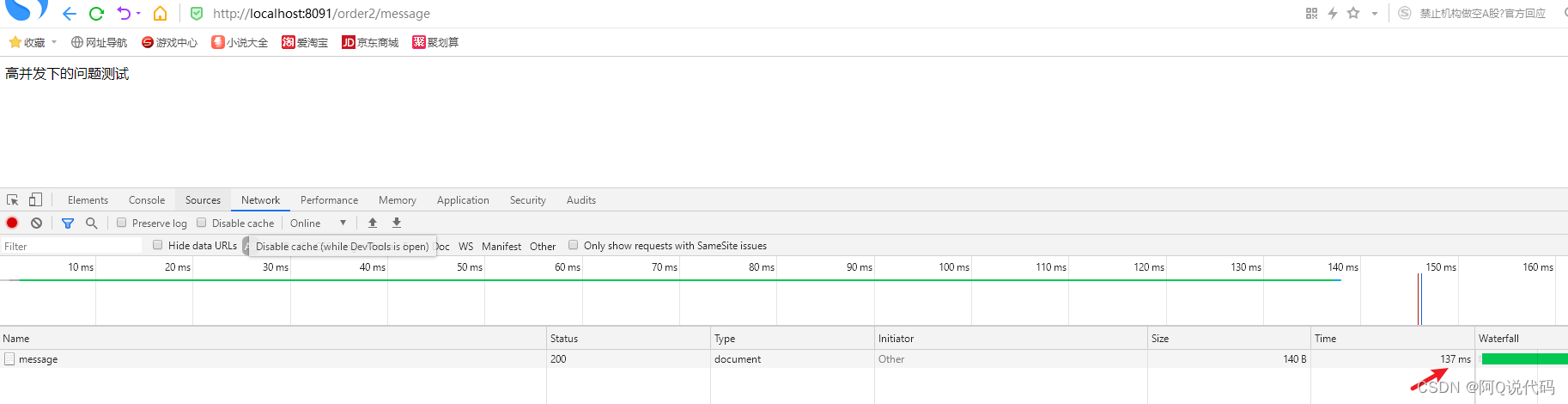

- 访问message方法观察效果

- 服务雪崩效应

- 常见容错方案

- 常见的容错思路

- 常见的容错组件

- 总结

欢迎来到阿Q社区

https://bbs.csdn.net/topics/617897123

高并发带来的问题

在微服务架构中,我们将业务拆分成一个个的服务,服务与服务之间可以相互调用,但是由于网络原因或者自身的原因,并不能保证服务的100%可用,如果单个服务出现问题,调用这个服务就会出现网络延迟,此时若有大量的网络涌入,会形成任务堆积,最终导致服务瘫痪。

接下来,我们来模拟一个高并发的场景

编写代码

@GetMapping("/{pid}") public ShopOrder order(@PathVariable("pid") Long pid) { log.info("客户下单,这时候要调用商品微服务查询商品信息。。。"); //通过fegin调用商品微服务 ShopProduct product = productService.findByPid(pid); log.info("商品信息,查询结果:" + JSON.toJSONString(product)); //模拟一次网络延时 try{ Thread.sleep(100); }catch (InterruptedException e) { e.printStackTrace(); } log.info("当前用户信息为自己,假设我们设置为1"); ShopOrder shopOrder = new ShopOrder(); shopOrder.setUid(1L); shopOrder.setUsername("公众号:阿Q说代码"); shopOrder.setPid(product.getId()); shopOrder.setPname(product.getPname()); //为了不产生太多垃圾数据,暂时不做订单保存 // orderService.save(shopOrder); return shopOrder; }修改配置

修改配置文件中 tomcat 的并发数

server: port: 8091 tomcat: #tomcat的最大并发值修改为10,默认是200 max-threads: 10压力测试

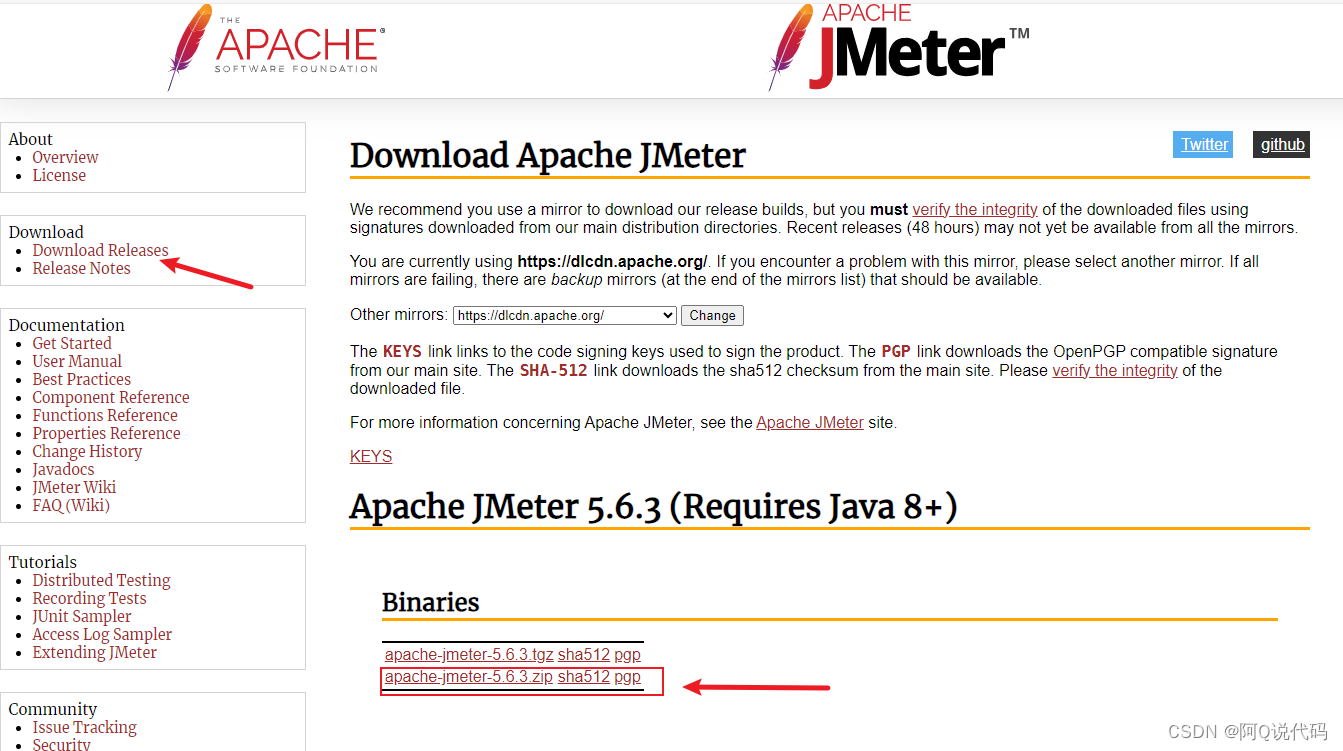

接下来使用压测工具,对请求进行压力测试

下载地址 https://jmeter.apache.org/

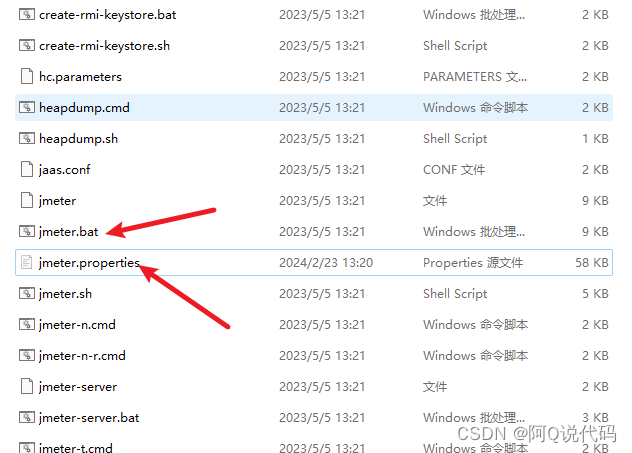

修改配置,并启动软件

进入 bin 目录,修改 jmeter.properties 文件中的语言支持为 language= zh_cn,然后点击 jmeter.bat 启动软件。

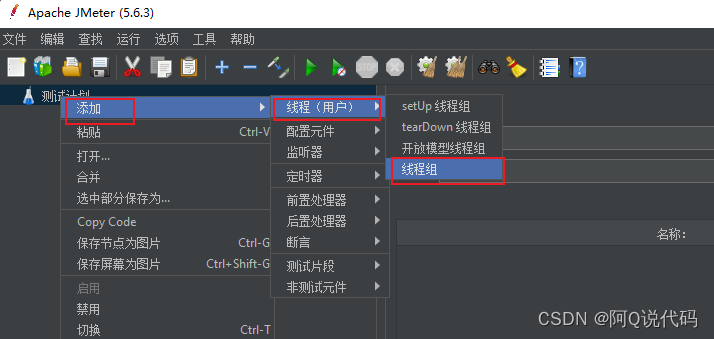

添加线程组

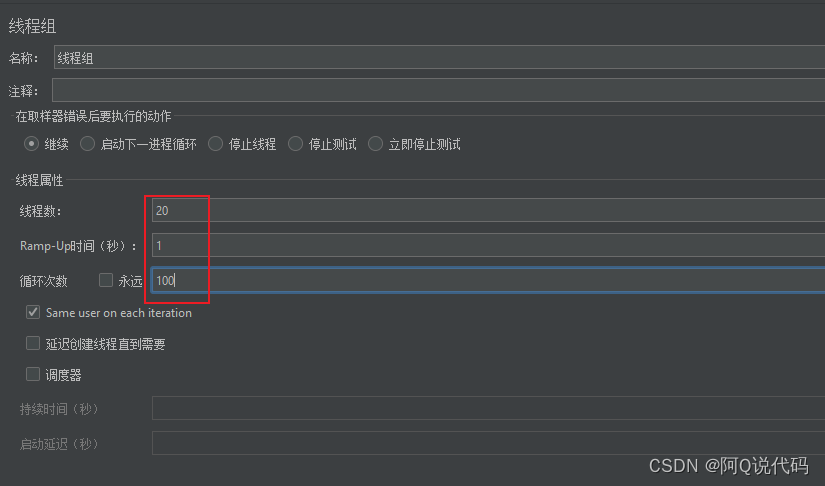

配置线程并发数

添加Http取样

配置取样,并启动测试

访问message方法观察效果

启动前

启动后

结论:此时会发现,由于 order 方法囤积了大量请求,导致 message 方法的访问变慢了,这就是服务雪崩的雏形。

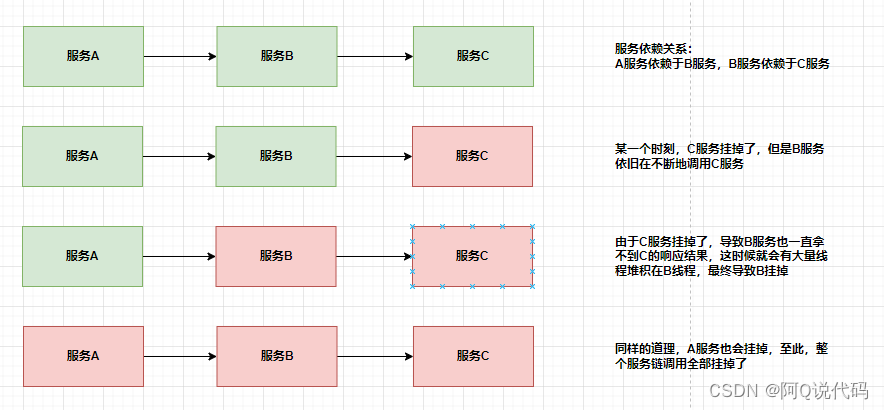

服务雪崩效应

在分布式系统中,由于网络原因或自身的原因,服务一般无法保证100%可用。如果一个服务出现了问题,调用这个服务就会出现线程阻塞的情况,此时若有大量的请求涌入,就会出现多条线程阻塞等待,进而导致服务瘫痪。

由于服务与服务之间的依赖性,故障会传播,会对整个微服务系统造成灾难性的严重后果,这就是服务故障的“雪崩效应”。

雪崩发生的原因多种多样,有不合理的容量设计,或者是高并发下某一个方法响应变慢,亦或是某台机器的资源耗尽。我们无法完全杜绝雪崩源头的发生,只有做好足够的容错,保证在一个服务发生问题,不会影响到其它服务的正常运行。也就是“雪落而不雪崩”。

常见容错方案

要防止雪崩的扩散,我们就要做好服务的容错,容错说白了就是保护自己不被猪队友拖垮的一些措施。下面介绍常见的服务容错思路和组件。

常见的容错思路

常见的容错思路有隔离、超时、限流、熔断、降级这几种,下面分别介绍一下。

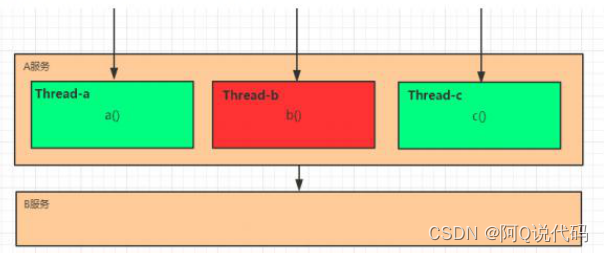

隔离

它是指将系统按照一定的原则划分为若干个服务模块,各个模块之间相对独立,无强依赖。当有故障发生时,能将问题和影响隔离在某个模块内部,而不扩散风险,不波及其它模块,不影响整体的系统服务。

常见的隔离方式有:线程池隔离和信号量隔离。

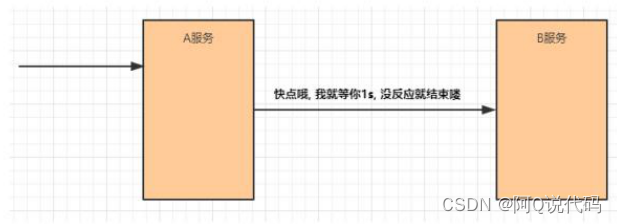

超时

在上游服务调用下游服务的时候,设置一个最大响应时间,如果超过这个时间,下游未作出反应,就断开请求,释放掉线程。

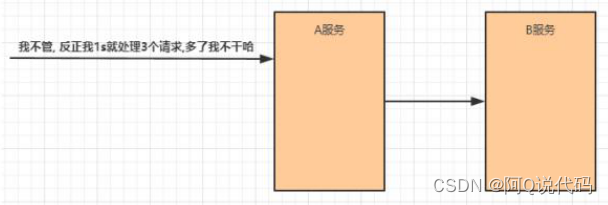

限流

限流就是限制系统的输入和输出流量已达到保护系统的目的。为了保证系统的稳固运行,一旦达到的需要限制的阈值,就需要限制流量并采取少量措施以完成限制流量的目的。

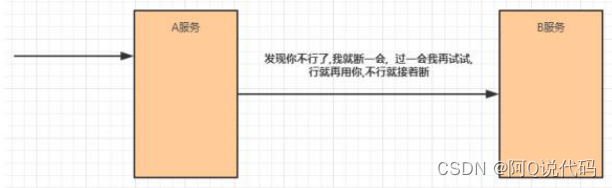

熔断

在互联网系统中,当下游服务因访问压力过大而响应变慢或失败,上游服务为了保护系统整体的可用性,可以暂时切断对下游服务的调用。这种牺牲局部,保全整体的措施就叫做熔断。

服务熔断一般有三种状态:

- 熔断关闭状态(Closed):服务没有故障时,熔断器所处的状态,对调用方的调用不做任何限制

- 熔断开启状态(Open):后续对该服务接口的调用不再经过网络,直接执行本地的fallback方法

- 半熔断状态(Half-Open):尝试恢复服务调用,允许有限的流量调用该服务,并监控调用成功率。如果成功率达到预期,则说明服务已恢复,进入熔断关闭状态;如果成功率仍旧很低,则重新进入熔断开启状态。

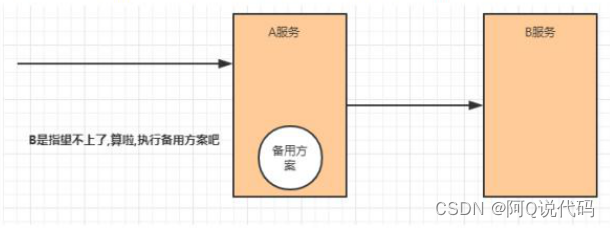

降级

降级其实就是为服务提供一个托底方案,一旦服务无法正常调用,就使用托底方案。

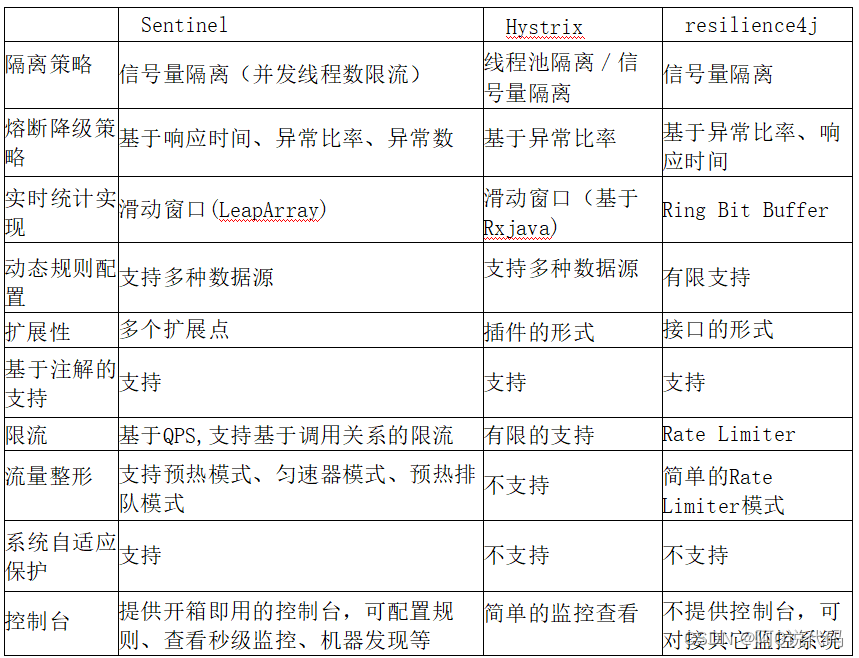

常见的容错组件

- Hystrix:Hystrix是由Netflix开源的一个延迟和容错库,用于隔离访问远程系统、服务或者第三方库,防止级联失败,从而提升系统的可用性与容错性。

- Resilience4J:Resilicence4J一款非常轻量、简单,并且文档非常清晰、丰富的熔断工具,这也是Hystrix官方推荐的替代产品。不仅如此,Resilicence4j还原生支持Spring Boot 1.x/2.x,而且监控也支持和prometheus等多款主流产品进行整合。

- Sentinel:Sentinel是阿里巴巴开源的一款断路器实现,本身在阿里内部已经被大规模采用,非常稳定。

下面是三个组件在各方面的对比:

总结

到这儿,高并发带来的问题及常见容错方案就结束了。下一篇将为大家带来容错组件 Sentinel 的文章,敬请期待吧!

后续的文章,我们将继续完善我们的微服务系统,集成更多的Alibaba组件。想要了解更多JAVA后端知识,请点击文末名片与我交流吧。留下您的一键三连,让我们在这个寒冷的东西互相温暖吧!