您的位置:上海毫米网络优化公司 > 网站优化分享 >

相关推荐recommended

- 解决Mysql异常【MySQLTransactionRollbackE

- MongoDB【四】查询与聚合框架

- 【已解决】.nginx: error while loading sh

- 【Rust】——项目实例:——命令行实例(一)

- 最新免费 ChatGPT、GPTs、AI换脸(Suno-AI音乐生成大

- IDEA 2024 配置 Maven 创建 Spring Boot 项

- 分布式系统架构中的相关概念

- OpenHarmony开发-系统烧录

- 前端Vue日常工作中--Watch数据监听

- 探索Django:打造高效、可扩展的Web应用(下)

- 解锁AI大模型潜力,让文案创作飞跃升级

- 【Rust】——Cargo工作空间

- 智慧工地管理平台APP源码基于物联网、云计算、大数据等技术

- Error running ‘Tomcat‘: Unable to o

- IDEA启动Springboot报错:无效的目标发行版:17 的解决办

- 计算机体系架构

- Vue实例挂载的过程

- STM32-SPI通信协议

- three.js 基础认识与简单应用

- k8s中,kubelet 出现问题, k8s-master node

- AI虽强,搜索引擎仍不可或缺

- JavaWeb项目:航班信息管理系统(tomcat+jsp)

- 【猫头虎科技角】解决Mysqlcom.mysql.cj.jdbc.ex

- mysql中find

- [架构之路-214]- UML-类图图解、详解、结构化、本质化讲解

- 爬个数据这么吃力?别慌,代理IP轻松解决跨境电商技术瓶颈

- 深入了解 Spring boot的事务管理机制:掌握 Spring 事

- 若依(前后端分离版)部署全流程 | 宝塔部署SpringBoot项目踩

- Docker进阶:容器与镜像的导入和导出

- VMware虚拟机桥接、NAT、仅主机三种网络模式的配置详解

小红书关键词爬虫

作者:mmseoamin日期:2024-03-20

标题

- 1 统计要收集的关键词,制作一个文件夹

- 2 爬取每一页的内容

- 3 爬取标题和内容

- 4 如果内容可以被查看,爬取评论内容

- 5 将结果进行汇总,并且每个帖子保存为一个json文件,具体内容

- 6 总结

1 统计要收集的关键词,制作一个文件夹

例如,我要收集旅游相关的,就收集:

旅游、旅行、旅游攻略,这些词,做成一个txt文件。

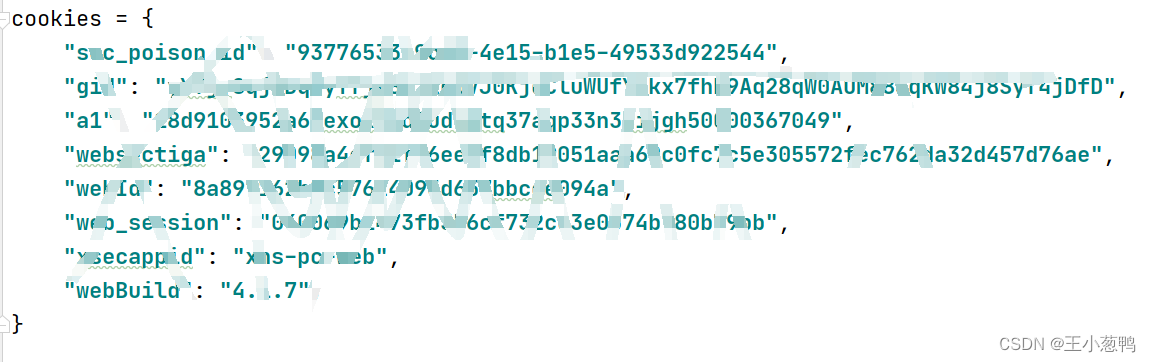

用一个浏览器登录上小红书账号,然后记录写cookies,例如:

2 爬取每一页的内容

主要使用request,js模块,将爬取的内容保存为res,里面包含一页20条数据。

info = re.sub(r'"page":".*?"', f'"page":"{page}"', info) ret = js.call('get_xs', api, info, cookies["a1"]) headers['x-s'], headers['x-t'] = ret['X-s'], str(ret['X-t']) response = requests.post(search_url, headers=headers, cookies=cookies, data=info.encode('utf-8')) res = response.json()3 爬取标题和内容

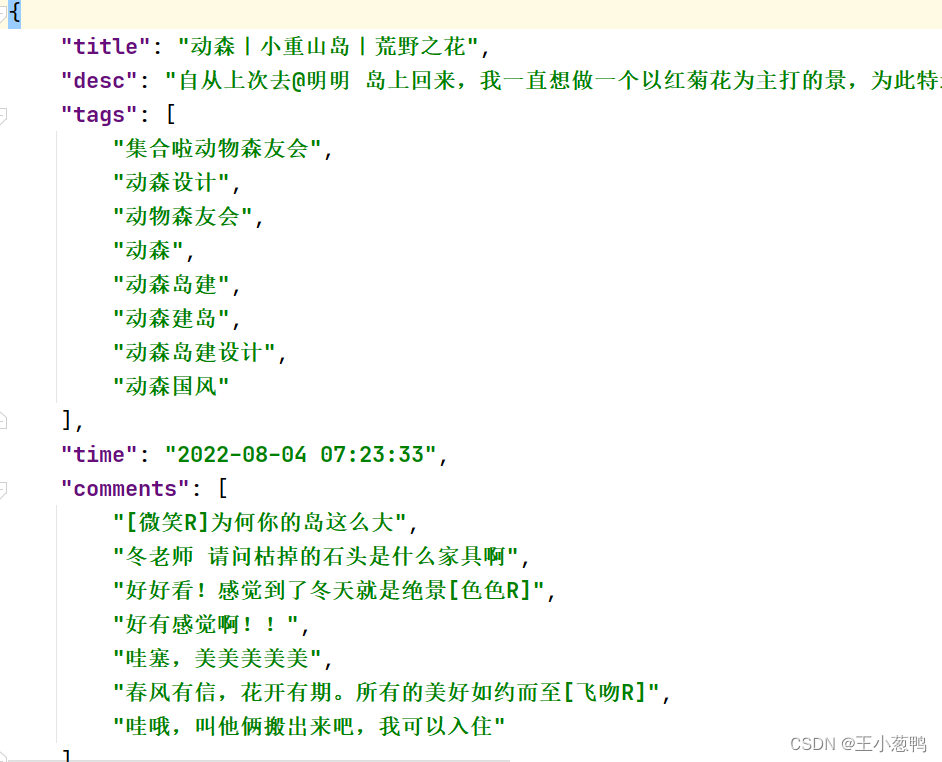

从每一个note里面解析出标题,内容等信息。

result = {} result["title"] = data['note_card']['title'] result["desc"] = data['note_card']['desc'].replace("\n", "").replace("\t", "") tags_temp = data['note_card']['tag_list'] tags = [] for tag in tags_temp: try: tags.append(tag['name']) except: pass result["tags"] = tags result["time"] = timestamp_to_str(data['note_card']['time'])4 如果内容可以被查看,爬取评论内容

每个帖子里面的评论的单独的url,需要根据id号进行拼接,所以根据第3节获取的user-id,进行拼接,然后再用get进行访问,最后获得每条评论,注意有些帖子是不能被查看的,所以需要进行判断。

note_id = url.split('/')[-1] comments_url = "https://edith.xiaohongshu.com/api/sns/web/v2/comment/page?note_id={}&image_scenes=FD_WM_WEBP,CRD_WM_WEBP".format( note_id) response = requests.get(comments_url, headers=headers, cookies=cookies) res = response.json() comments = [] for line in res["data"]["comments"]: comment_str = line["content"] comments.append(comment_str)5 将结果进行汇总,并且每个帖子保存为一个json文件,具体内容

包含:标题,具体内容,标题,创建时间,评论内容。每个关键词一个文件夹。

6 总结

详细代码私聊,注意本内容没有爬取图片,如果需要可以添加。