- ELFK日志分析系统之搭建ELF+Filebeaat+Zookeepe

- Java项目:基于Springboot框架实现的校园求职招聘系统(sp

- 23 | 负载均衡:选择Nginx还是OpenResty?

- SpringBoot【问题 05】PostgreSQL数据库启用SSL

- 如何利用SpringSecurity进行认证与授权

- MySQL DDL 通用语法

- K8S--安装metrics-server,解决error: Metr

- IDEA2023版本创建spring boot项目时,Java版本无法

- mysql workbench使用教程

- Python 操作 MySQL 的5种方式

- LQR算法原理和代码实现

- 【Nginx】Nginx启动显示80端口占用问题的解决方案

- Spring Boot启动时执行初始化操作的几种方式

- 【前端】i18n Ally插件使用

- nginx重启失败:Job for nginx.service fai

- Golang 开发实战day08 - Multiple Return

- SQL拆分字段内容(含分隔符)

- 在 PostgreSQL 中,查看表是否被锁住以及解锁语句

- three.js 基础认识与简单应用

- Nginx 日志配置

- SpringBoot 整合Swagger2

- 这里有份百度Create大会超长剧透,请查收!

- 数据结构——链表

- 【Go语言快速上手(三)】数组, 切片与映射

- Linux上启动Nginx失败:Job for nginx.servi

- webrtc视频播放器(ZLMRTCClient.js)

- 【IDEA】2023版IDEA安装破解教程

- Mysql 报 java.sql.SQLException:null,

- 看懂PLSQL执行计划

- Rust 语言 GUI 用户界面框架汇总(持续更新)

SQL优化

插入数据

insert

一次插入数据和批量插入数据

insert into tb_test (id, name) values (1,'Tom'); insert into tb_test (id, name) values (1,'Tom'),(2,'Jack'),(3,'Jerry');

- 优化方案:

手动控制事务,且按主键顺序插入。

start transaction; insert into tb_test (id, name) values (1,'Tom'),(2,'Jack'),(3,'Jerry'); commit;

大批量插入数据

如果一次性需要插入大批量数据(比如: 几百万的记录),使用insert语句插入性能较低,此时可以使

用MySQL数据库提供的load指令进行插入。操作如下:

-- 客户端连接服务端时,加上参数 -–local-infile mysql –-local-infile -u root -p -- 设置全局参数local_infile为1,开启从本地加载文件导入数据的开关 set global local_infile = 1; -- 执行load指令将准备好的数据,加载到表结构中 load data local infile '/root/xxxsql.sql' into table tb_user fields terminated by ',' lines terminated by '\n' ;

主键顺序插入性能高于乱序插入

主键优化

在插入数据时,主键顺序插入性能高于乱序插入。

-

分析:

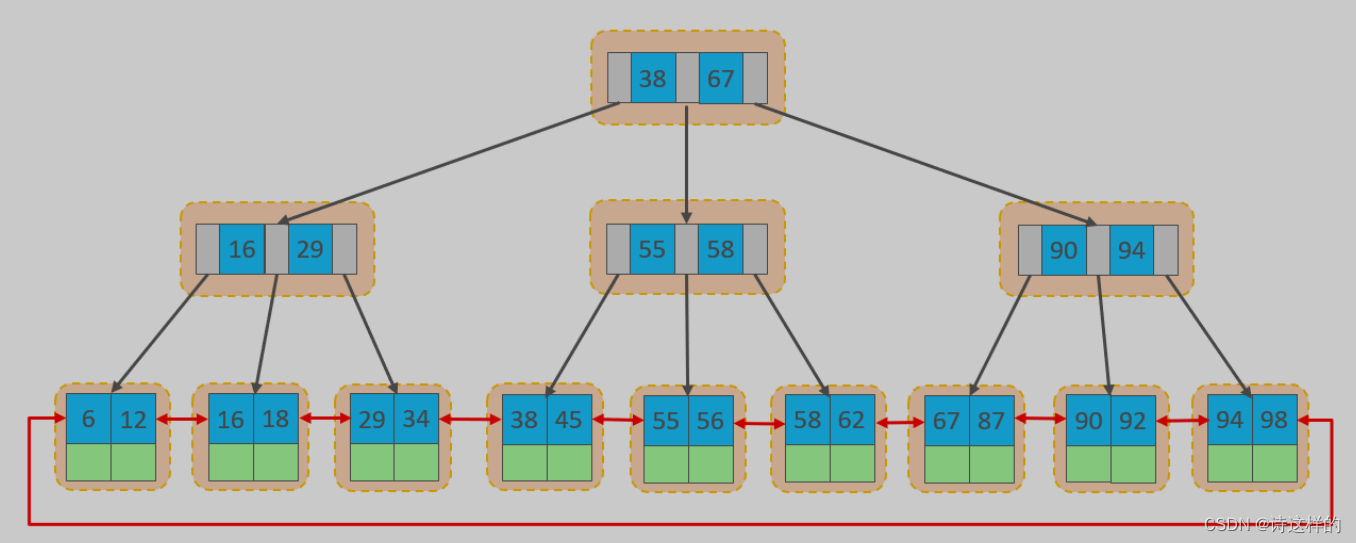

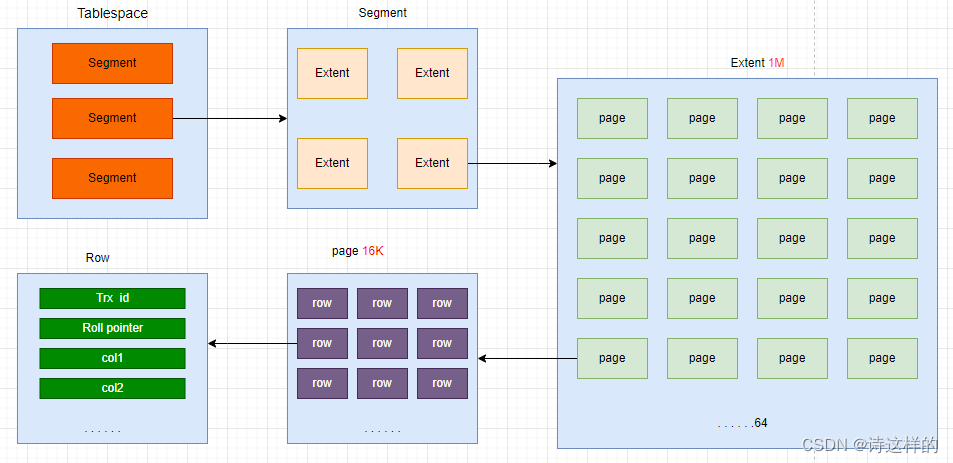

在InnoDB存储引擎中,表数据都是根据主键顺序组织存放的。这种存储方式的表称为索引组织表(index organized table IOT)。

InnoDB存储引擎的逻辑结构如下图。

在InnoDB引擎中,数据行是记录在逻辑结构 page 页中的,而每一个页的大小是固定的,默认16K。那也就意味着, 一个页中所存储的行也是有限的,如果插入的数据行row在该页存储不小,将会存储到下一个页中,页与页之间会通过指针连接(双链表)。

-

页分裂

页可以为空,也可以填充一半,也可以填充100%。每个页包含了2-N行数据(如果一行数据过大,会行溢出),根据主键排列。

- 正常按照主键顺序插入时,行数据放到页中,如果当前页已满,或剩余页空间不够新插入的行数据不内存,写入第二页继续顺序插入,页与页之间通过指针相互连接。

- 主键乱序插入时,会存在页分裂,比较耗费性能。

-

页合并

- 当我们对已有的数据删除时,达到一定的归并阈值(MERGE_THRESHOLD),相邻的页会合并,优化空间。

- 索引设计原则

- 满足业务需求的情况下,尽量降低主键的长度。

- 插入数据时,尽量选择顺序插入,选择使用AUTO_INCREMENT自增主键。

- 尽量不要使用UUID做主键或者是其他自然主键,如身份证号。

- 业务操作时,避免对主键的修改。

order by优化

- 根据排序字段建立合适的索引,多字段排序时,也遵循最左前缀法则。

- 尽量使用覆盖索引。

- 多字段排序, 一个升序一个降序,此时需要注意联合索引在创建时的规则(ASC/DESC)。

- 如果不可避免的出现filesort,大数据量排序时,可以适当增大排序缓冲区大小 sort_buffer_size(默认256k)。

group by优化

- 在分组操作时,可以通过索引来提高效率。

- 分组操作时,索引的使用也是满足最左前缀法则的。

limit优化

在数据量比较大时,如果进行limit分页查询,在查询时,越往后,分页查询效率越低。

例如select * from tb_user limit 9000000,10;

优化思路: 一般分页查询时,通过创建 覆盖索引 能够比较好地提高性能,可以通过覆盖索引加子查

询形式进行优化。

例如:

explain select * from tb_sku t , (select id from tb_sku order by id limit 2000000,10) a where t.id = a.id;

count优化

count() 是一个聚合函数,对于返回的结果集,一行行地判断,如果 count 函数的参数不是NULL,累计值就加 1,否则不加,最后返回累计值。

用法:count(*)、count(主键)、count(字段)、count(数字)

count用法 含义 count(主键) InnoDB 引擎会遍历整张表,把每一行的 主键id 值都取出来,返回给服务层。服务层拿到主键后,直接按行进行累加(主键不可能为null) count(字段) 没有not null 约束 : InnoDB 引擎会遍历整张表把每一行的字段值都取出来,返回给服务层,服务层判断是否为null,不为null,计数累加。有not null 约束:InnoDB 引擎会遍历整张表把每一行的字段值都取出来,返回给服务层,直接按行进行累加。 count(数字) InnoDB 引擎遍历整张表,但不取值。服务层对于返回的每一行,放一个数字“1”进去,直接按行进行累加。 count(*) InnoDB引擎并不会把全部字段取出来,而是专门做了优化,不取值,服务层直接按行进行累加。 update 优化

在MySQL的默认引擎中,InnoDB会在使用 update 操作时,加锁。

如果是按照索引的字段update,会加行锁,否则加表锁。

例如一张表中的id是主键,name是属性值。

update tb_user set name = 'zhangsan' where id = 1 ,上的是行锁,其他用户可以对当前tb_user表中的其他行数据进行update修改,但如果是按照非索引字段修改update tb_user set name = 'lisi' where name = 'zhangsan',上的是表锁,其他用户无法更改当前表的任何数据,直到得到表锁的事务提交。

InnoDB的行锁是针对索引加的锁,不是针对记录加的锁 ,并且该索引不能失效,否则会从行锁升级为表锁 。

- 索引设计原则

- 当我们对已有的数据删除时,达到一定的归并阈值(MERGE_THRESHOLD),相邻的页会合并,优化空间。

-