您的位置:上海毫米网络优化公司 > 网站优化分享 >

相关推荐recommended

- nginx设置开启自启

- Spring Boot国际化i18n配置指南

- Error running ‘Tomcat‘: Unable to o

- 革新鞋服零售:数据驱动的智能商品管理 解锁库存优化与高效增长

- Spring容器结构

- Node-sass与Node.js版本对应关系的深入探讨

- Newspaper库,一个新手也能快速上手的爬虫库

- 【讯飞星火大模型AI】SpringBoot项目快速接入讯飞星火API

- GOPROXY 代理设置

- 【基于Ubuntu下Yolov5的目标识别】保姆级教程 | 虚拟机安装

- IDEA2023版本创建spring boot项目时,Java版本无法

- MySQL篇—启动或者关闭linux下MySQL数据库的多种方式

- Spring之 国际化:i18n

- Jenkins 命令无法后台运行,使用BUILD

- 【Spring】SpringBoot整合MybatisPlusGern

- 如何在SpringBoot集成mapstruct实现类型转换?一篇文章

- Spring Boot框架的过滤器(Filters)和拦截器(Inte

- 一文详解SpringBoot 定时任务(cron表达式)

- springboot整合支付宝沙箱支付和退款

- 图解缓存淘汰算法 LRU、LFU | 最近最少使用、最不经常使用算法

- Rust面试宝典第3题:找不同的数

- 华为eNSP配置MSTP实验

- 云计算——虚拟化VMware ESXI 7.0安装(一)

- Rust入门:C++和Rust动态库(dll)的相互调用

- 【数据库】数据库的介绍、分类、作用和特点,AI人工智能数据如何存储

- 数组扁平化的三种方式

- 2023年Java初中高架构后端真实面试题大全(有详细答案)--高频真

- python——Django 框架

- Mac清理软件cleanmymac x4.14.4破解版,2024年有

- 简单易懂:Axios 如何取消请求的两种方法

基于Linux的Spark安装与环境配置

作者:mmseoamin日期:2024-03-20

文章目录

- 基于Linux的Spark安装与环境配置

- 1、Hadoop测试

- 1.1 启动hadoop

- 1.2 再次启动hadoop

- 1.3 查看是否成功

- 2、Scala安装与配置

- 2.1 下载scala

- 2.2 解压并重命名

- 2.3 配置环境

- 2.4 测试

- 3、Spark安装与配置

- 3.1 下载Spark

- 3.2 解压并重命名

- 3.3 配置环境

- 3.4 配置spark-env.sh

- 3.5 配置slaves(好像不需要)

- 3.6 启动(报错)

- 3.7 测试

- 3.8 查看Spark版本

基于Linux的Spark安装与环境配置

1、Hadoop测试

因为Spark是基于Hadoop上工作的,所以当我们使用Spark框架时,必须要确保Hadoop能够正常运行:

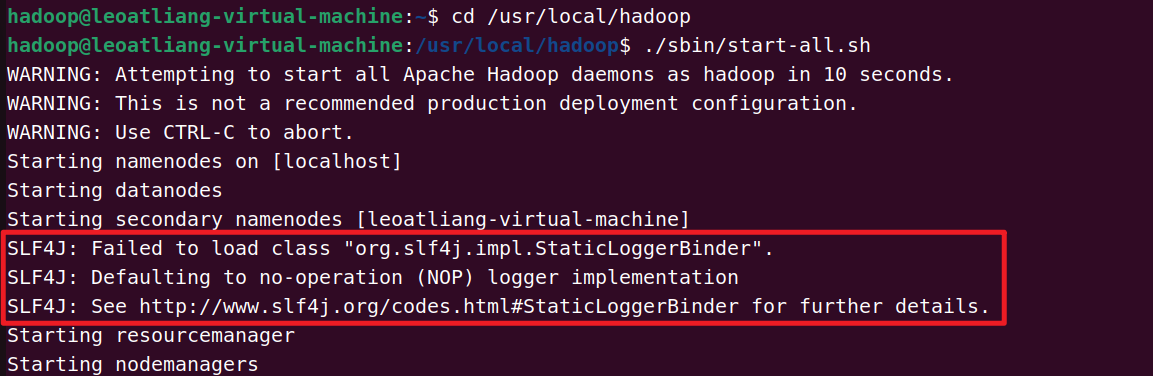

1.1 启动hadoop

cd /usr/local/hadoop ./sbin/start-all.sh

有BUG,内容如下:

SLF4J: Failed to load class "org.slf4j.impl.StaticLoggerBinder". SLF4J: Defaulting to no-operation (NOP) logger implementation SLF4J: See http://www.slf4j.org/codes.html#StaticLoggerBinder for further details.

解决方法:SLF4J:Failed to load class org.slf4j.impl.StaticLoggerBinder.

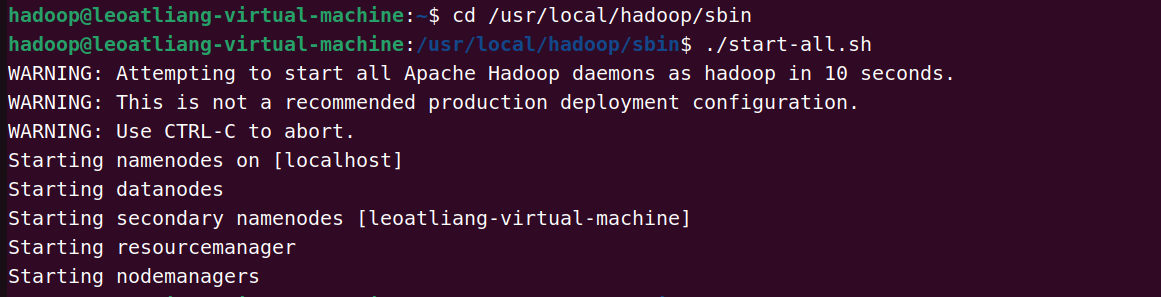

1.2 再次启动hadoop

cd /usr/local/hadoop/sbin ./start-all.sh

1.3 查看是否成功

jps

2、Scala安装与配置

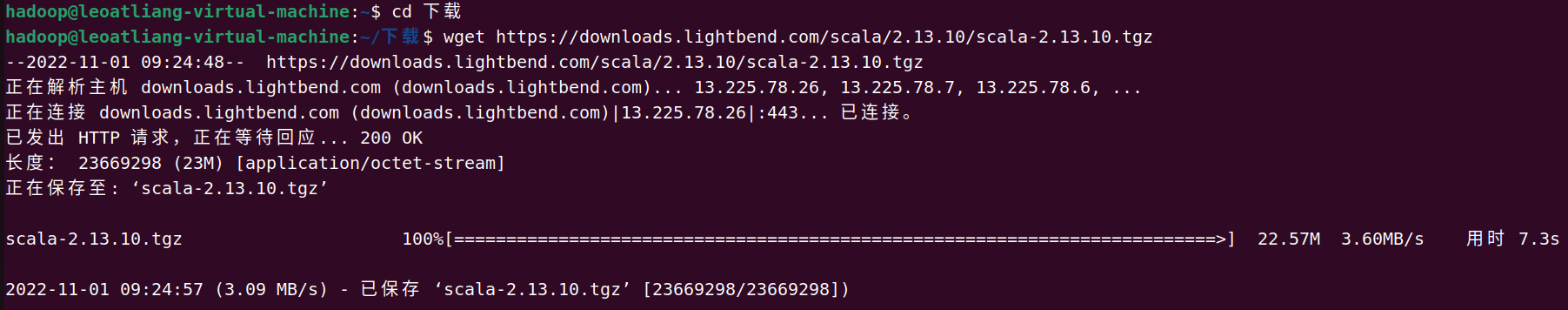

2.1 下载scala

官方网址:https://www.scala-lang.org/download/2.13.10.html

使用wget命令下载scala:

wget https://downloads.lightbend.com/scala/2.13.10/scala-2.13.10.tgz

2.2 解压并重命名

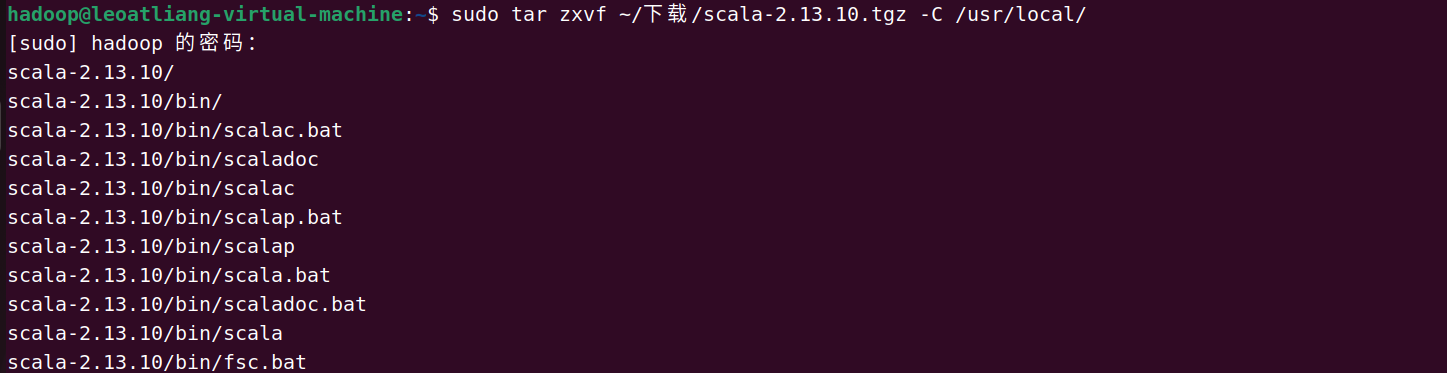

sudo tar zxvf ~/下载/scala-2.13.10.tgz -C /usr/local/ # 解压 cd /usr/local sudo mv scala-2.13.10 scala # 重命名

2.3 配置环境

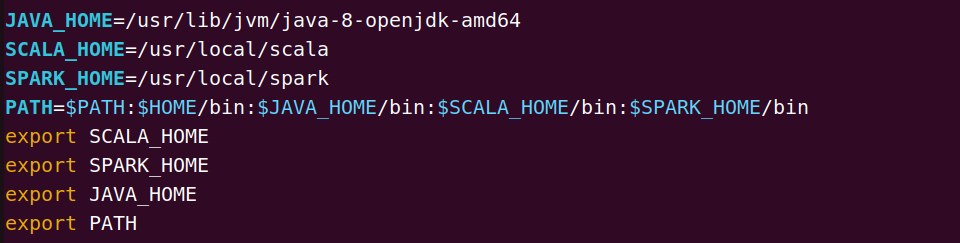

# 1.编辑环境变量 sudo vi ~/.bashrc # 2.使其生效 source ~/.bashrc

2.4 测试

scala -version

3、Spark安装与配置

3.1 下载Spark

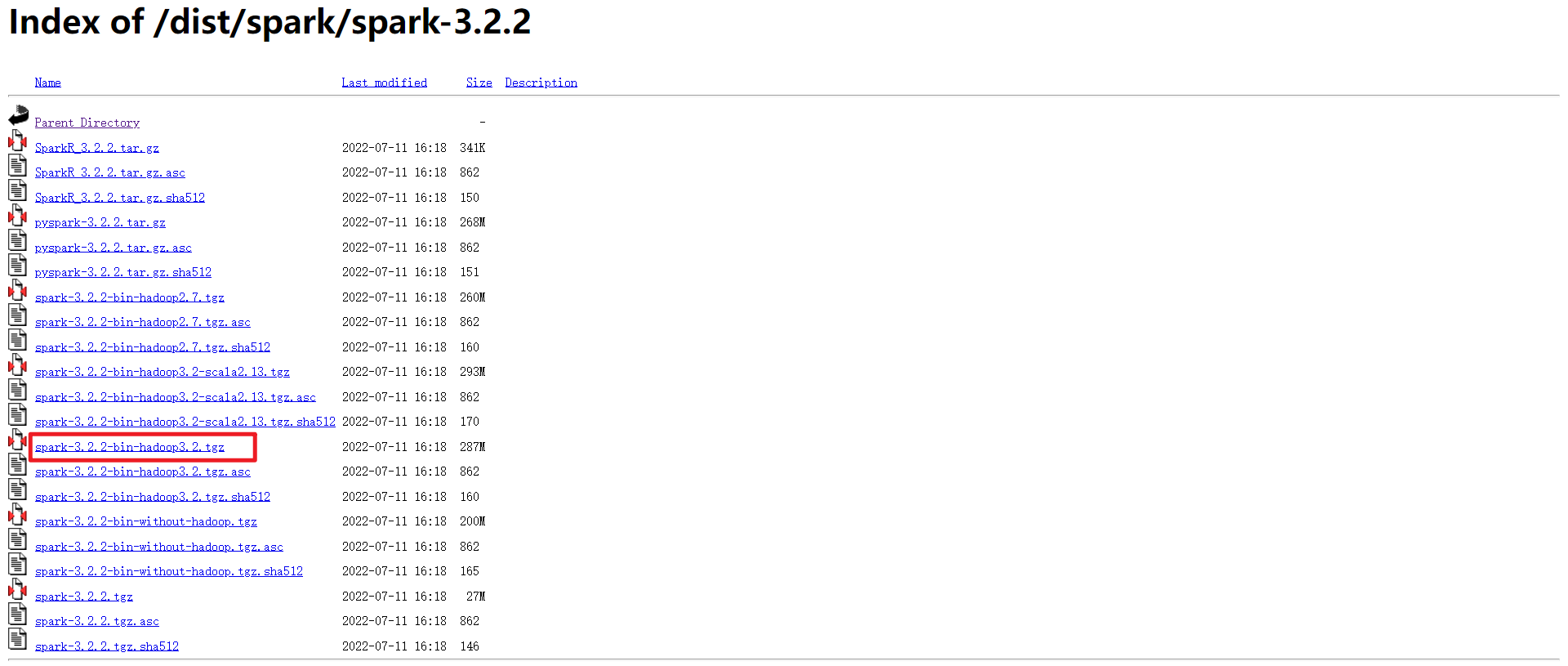

下载网址:https://archive.apache.org/dist/spark/spark-3.2.2/

使用wget命令进行下载:

wget https://archive.apache.org/dist/spark/spark-3.2.2/spark-3.2.2-bin-hadoop3.2.tgz

3.2 解压并重命名

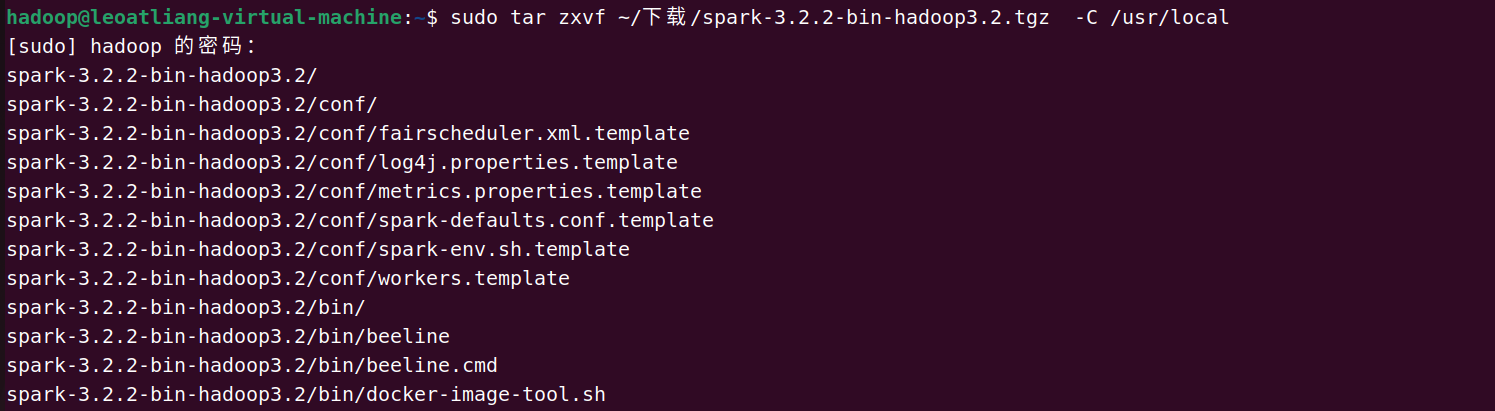

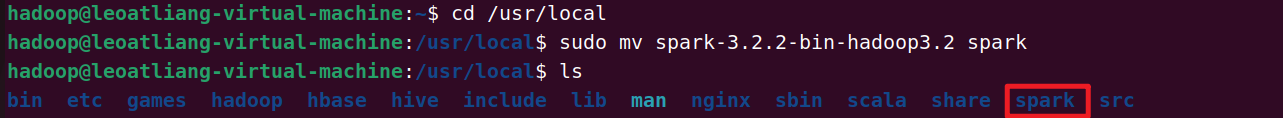

# 1.解压 sudo tar zxvf ~/下载/spark-3.2.2-bin-hadoop3.2.tgz -C /usr/local # 2.重命名 cd /usr/local sudo mv spark-3.2.2-bin-hadoop3.2 spark

3.3 配置环境

# 1.编辑环境变量 sudo vi ~/.bashrc # 2.使其生效 source ~/.bashrc

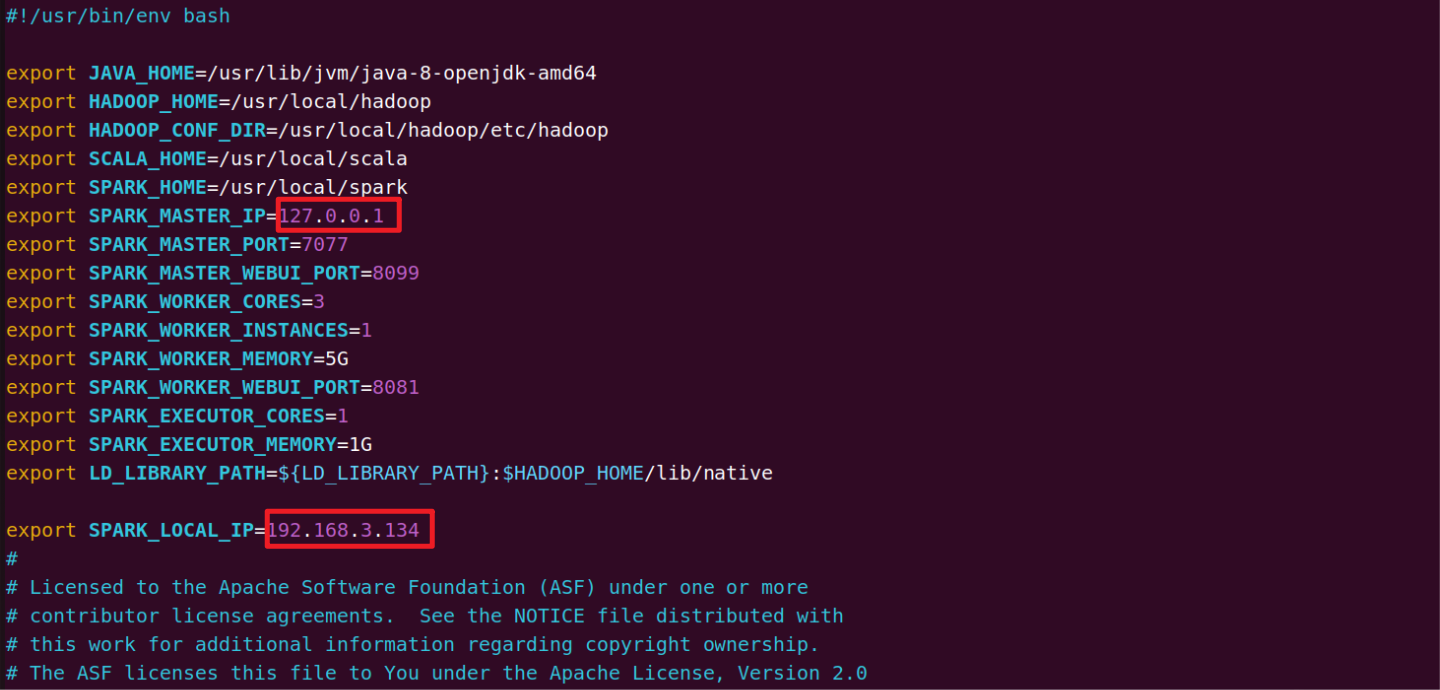

3.4 配置spark-env.sh

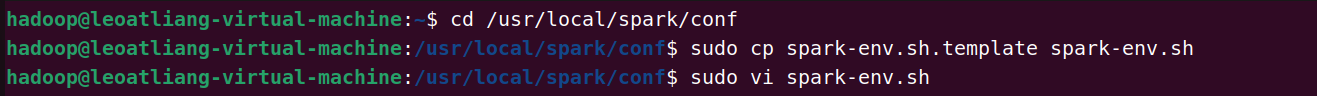

进入到配置目录并打开spark-env.sh文件:

cd /usr/local/spark/conf sudo cp spark-env.sh.template spark-env.sh sudo vi spark-env.sh

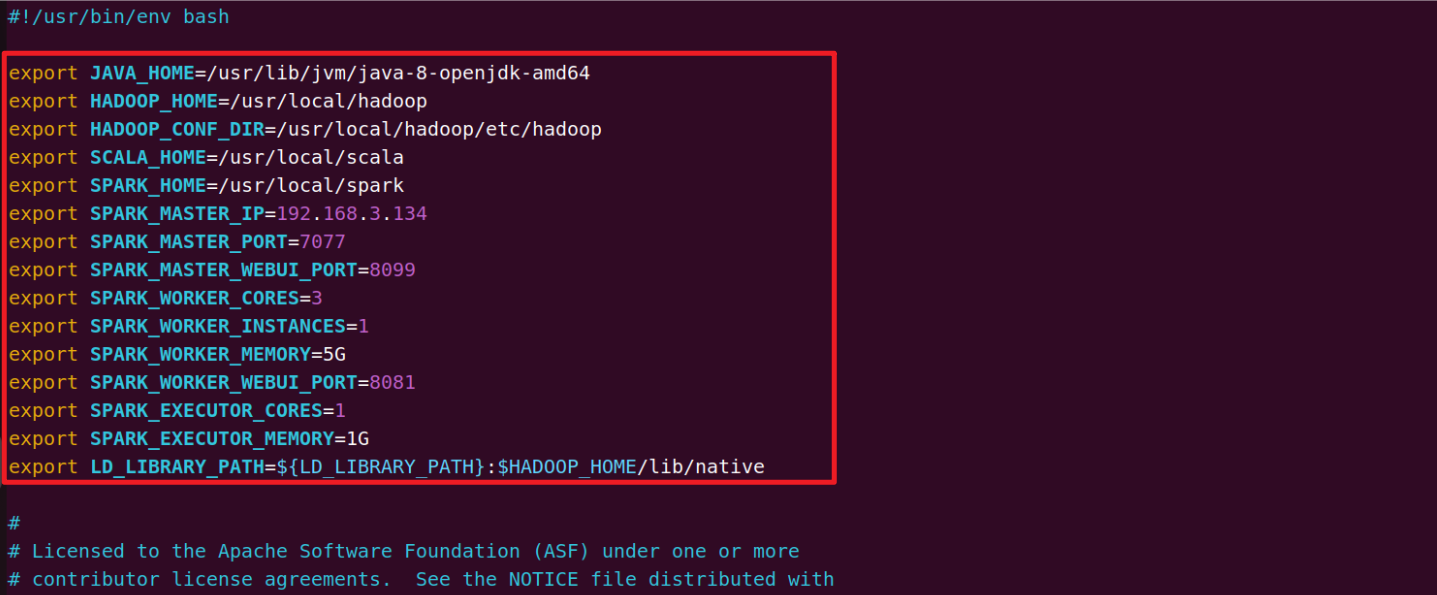

添加以下内容:

export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64 export HADOOP_HOME=/usr/local/hadoop export HADOOP_CONF_DIR=/usr/local/hadoop/etc/hadoop export SCALA_HOME=/usr/local/scala export SPARK_HOME=/usr/local/spark export SPARK_MASTER_IP=192.168.3.134 export SPARK_MASTER_PORT=7077 export SPARK_MASTER_WEBUI_PORT=8099 export SPARK_WORKER_CORES=3 export SPARK_WORKER_INSTANCES=1 export SPARK_WORKER_MEMORY=5G export SPARK_WORKER_WEBUI_PORT=8081 export SPARK_EXECUTOR_CORES=1 export SPARK_EXECUTOR_MEMORY=1G export LD_LIBRARY_PATH=${LD_LIBRARY_PATH}:$HADOOP_HOME/lib/native

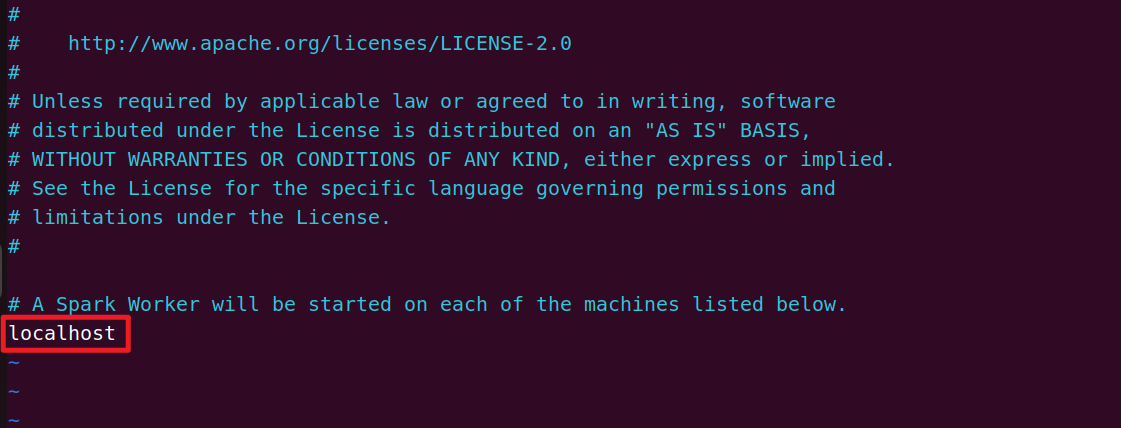

3.5 配置slaves(好像不需要)

cd /usr/local/spark/conf sudo vi workers.template

发现slaves文件里为localhost即本机地址,当前为伪分布式,因此不用修改!但要执行以下:

sudo cp workers.template slaves

3.6 启动(报错)

启动sbin目录下的start-master.sh以及start-slaves.sh(前提是hadoop已启动):

cd /usr/local/spark sudo ./sbin/start-master.sh sudo ./sbin/start-slaves.sh

报错!!!

3.7 测试

通过运行Spark自带的示例,验证Spark是否安装成功:

cd /usr/local/spark ./bin/run-example SparkPi

报错信息如下:

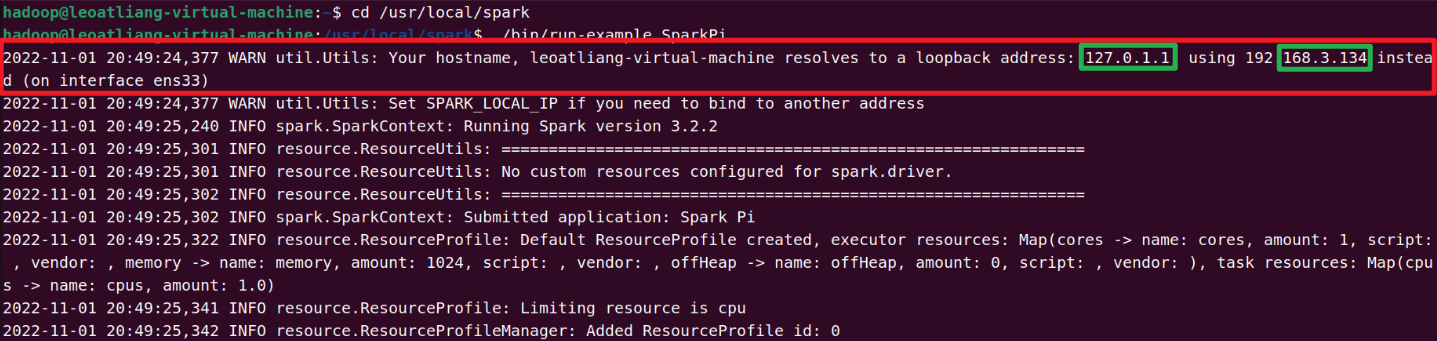

2022-11-01 20:49:24,377 WARN util.Utils: Your hostname, leoatliang-virtual-machine resolves to a loopback address: 127.0.1.1; using 192.168.3.134 instead (on interface ens33)

参考博客:Spark启动:WARN util.Utils: Your hostname, … resolves to a loopback address: …; using … instead

修改配置文件,配置 SPARK_LOCAL_IP 变量即可:

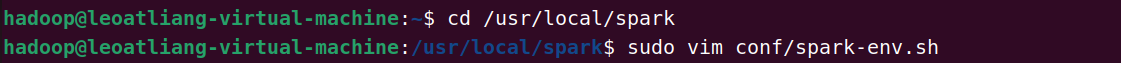

cd /usr/local/spark sudo vim conf/spark-env.sh # 添加以下内容: export SPARK_LOCAL_IP=192.168.3.134 # 自己输出对应的IP

再次测试:

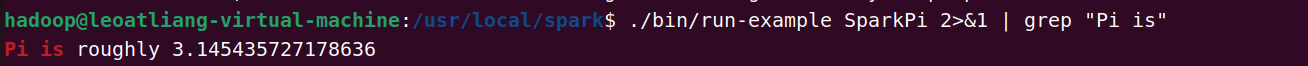

BUG解决!!!

执行时会输出非常多的运行信息,输出结果不容易找到,可以通过 grep 命令进行过滤:

./bin/run-example SparkPi 2>&1 | grep "Pi is"

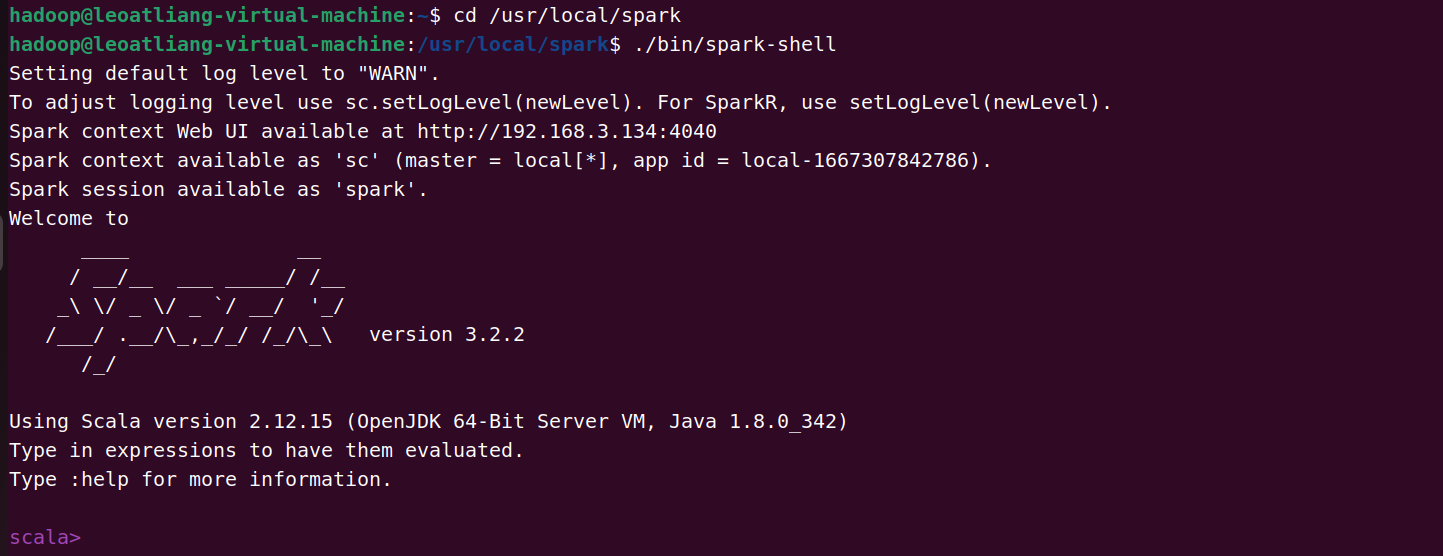

3.8 查看Spark版本

cd /usr/local/spark ./bin/spark-shell