- MySQL解决count查询慢而写的分页查询总量缓存器

- AI大模型探索之路-实战篇2:基于CVP架构-企业级知识库实战落地

- PostgreSQL的date

- 【爬虫实战】python文本分析库——Gensim

- idea设置自动编译spring boot代码,idea代码修改后无须

- 「PHP系列」PHP E-mail 注入防止注入

- 蓝桥杯(填空题)

- FlexLua:简化开发的LoRa无线氨气传感器技术

- 第十三届蓝桥杯Java B 组国赛 C 题——左移右移(AC)

- 每日五道java面试题之spring篇(六)

- -bash: hadoop: 未找到命令

- Mysql中 order by 多个字段排序

- 高级Java开发工程师手把手教你用AI人工智能帮你写JAVA代码实际案

- SpringBoot部署一 Windows服务器部署

- Vue实例挂载的过程

- nginx-图片模块

- 大数据可视化算法推荐情感分析——基于Django电影评论数据可视化分析

- Docker - 基本概念、与虚拟机的区别、架构、镜像操作、容器操作、

- Loading class `com.mysql.jdbc.Drive

- 基于springboot的酒店管理系统论文

- Python赋能AI数据分析开启人工智能新时代

- 【Docker系列】容器访问宿主机的Mysql

- MySQL 中内连接、左连接、右连接有什么区别?

- Cause: org.springframework.jdbc.Can

- RabbitMQ与RocketMQ:消息队列的两大强者对比

- jenkins+gitlab配置

- nginx设置开启自启

- Python Flask-Mail实现邮件发送

- 【python】深入探讨flask是如何预防CSRF攻击的

- spring boot相关漏洞之零散笔记

👽发现宝藏

前些天发现了一个巨牛的人工智能学习网站,通俗易懂,风趣幽默,忍不住分享一下给大家。【点击进入巨牛的人工智能学习网站】。

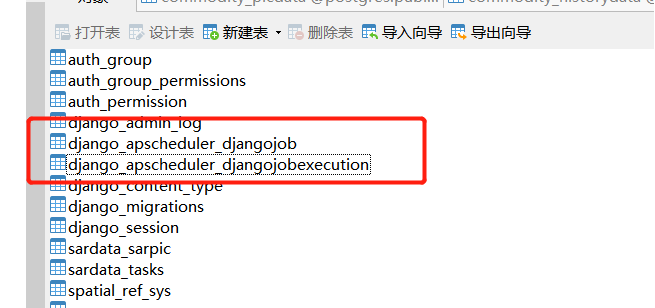

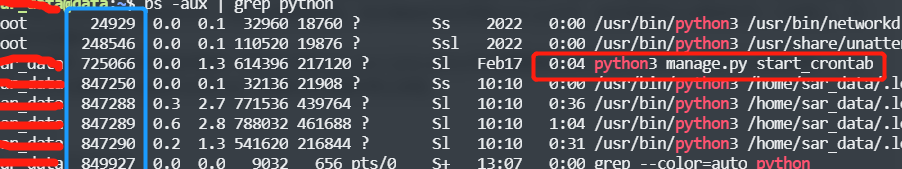

在Web开发中,处理定时任务和后台任务队列是很常见的需求。Django作为一个功能强大的Web框架,提供了多种方式来实现这些任务。本文将介绍如何在Django中实践定时任务和后台任务队列,并提供案例代码示例。

1. 定时任务的实现

在Django中,可以使用Celery这样的任务队列库结合Celery Beat来实现定时任务。下面是一个简单的示例:

首先,安装Celery和Celery Beat:

pip install celery

然后,配置Celery:

# settings.py CELERY_BROKER_URL = 'amqp://guest:guest@localhost' CELERY_RESULT_BACKEND = 'rpc://'

接着,创建一个Celery实例和定时任务:

# tasks.py

from celery import Celery

app = Celery('tasks', broker='amqp://guest:guest@localhost')

@app.task

def add(x, y):

return x + y

运行Celery Beat:

celery -A your_project_name beat -l info

现在,你可以在你的应用程序中调用add.delay(x, y)来执行定时任务。

2. 后台任务队列的实现

在Django中,你还可以使用Django Q 这样的库来实现后台任务队列。下面是一个示例:

首先,安装Django Q:

pip install django-q

然后,将它添加到你的INSTALLED_APPS中:

# settings.py

INSTALLED_APPS = [

...

'django_q',

...

]

接着,配置Django Q:

# settings.py

Q_CLUSTER = {

'name': 'your_project_name',

'workers': 4,

'timeout': 90,

'retry': 120,

'queue_limit': 50,

'bulk': 10,

'orm': 'default',

'save_limit': 250,

'cpu_affinity': 1,

'label': 'Django Q',

'redis': {

'host': 'localhost',

'port': 6379,

'db': 0,

'password': 'your_password',

'socket_timeout': 5,

'retry_on_timeout': True,

'socket_connect_timeout': 1,

'socket_keepalive': True,

'socket_keepalive_options': {

'TCP_KEEPIDLE': 60,

},

},

}

创建一个后台任务:

# views.py

from django_q.tasks import async_task

def my_background_task():

# 你的后台任务逻辑

pass

def some_view(request):

async_task(my_background_task)

return HttpResponse('Task started!')

3. 使用示例

3.1. 定时任务示例

假设我们有一个简单的Django应用,其中有一个计算两个数之和的函数。我们希望每隔一段时间执行这个函数并将结果记录到数据库中。首先,我们创建一个模型来保存计算结果:

# models.py

from django.db import models

class CalculationResult(models.Model):

result = models.IntegerField()

created_at = models.DateTimeField(auto_now_add=True)

然后,我们使用Celery来执行定时任务:

# tasks.py

from celery import Celery

from .models import CalculationResult

app = Celery('tasks', broker='amqp://guest:guest@localhost')

@app.task

def add(x, y):

result = x + y

CalculationResult.objects.create(result=result)

return result

现在,我们可以在我们的视图或其他地方调用add.delay(x, y)来执行这个定时任务。

3.2. 后台任务队列示例

假设我们的应用程序允许用户上传大型文件,并且我们希望在后台处理这些文件以提取有用的信息,例如文件大小和文件类型。我们可以使用Django Q来处理这些后台任务:

# views.py

from django_q.tasks import async_task

from .models import UploadedFile

def process_uploaded_file(file_id):

file_obj = UploadedFile.objects.get(id=file_id)

# 处理文件的逻辑

file_obj.processed = True

file_obj.save()

def handle_uploaded_file(file):

# 处理文件上传逻辑

file_obj = UploadedFile.objects.create(file=file)

async_task(process_uploaded_file, file_obj.id)

def upload_file(request):

if request.method == 'POST':

form = UploadFileForm(request.POST, request.FILES)

if form.is_valid():

handle_uploaded_file(request.FILES['file'])

return HttpResponse('File uploaded successfully!')

else:

form = UploadFileForm()

return render(request, 'upload.html', {'form': form})

在上面的例子中,当用户上传文件时,我们将文件保存到数据库中,并使用async_task将处理文件的函数放入后台任务队列中。

这段代码是一个 Django 应用的视图代码,主要实现了文件上传和异步处理上传文件的功能。我来逐步解析一下:

-

导入模块:

from django_q.tasks import async_task from .models import UploadedFile

这里导入了 async_task 函数,用于执行异步任务,并导入了自定义的模型 UploadedFile,该模型似乎用于存储上传的文件信息。

-

定义异步任务函数:

def process_uploaded_file(file_id): file_obj = UploadedFile.objects.get(id=file_id) # 处理文件的逻辑 file_obj.processed = True file_obj.save()这个函数用于处理上传的文件。通过传入的 file_id,它从数据库中获取相应的 UploadedFile 对象,然后对文件进行处理(在注释中标记为“处理文件的逻辑”),最后保存更改。

-

处理上传的文件函数:

def handle_uploaded_file(file): # 处理文件上传逻辑 file_obj = UploadedFile.objects.create(file=file) async_task(process_uploaded_file, file_obj.id)这个函数用于处理上传的文件。它首先创建一个 UploadedFile 对象,将上传的文件 file 存储到数据库中,并将处理该文件的任务委派给 async_task 异步执行。在这里,async_task 调用了 process_uploaded_file 函数,传递了 file_obj.id。

-

处理文件上传的视图函数:

def upload_file(request): if request.method == 'POST': form = UploadFileForm(request.POST, request.FILES) if form.is_valid(): handle_uploaded_file(request.FILES['file']) return HttpResponse('File uploaded successfully!') else: form = UploadFileForm() return render(request, 'upload.html', {'form': form})这个函数是处理文件上传的视图函数。当收到 POST 请求时,它首先通过 UploadFileForm 校验表单数据,如果表单数据有效,则调用 handle_uploaded_file 函数来处理上传的文件,并返回一个成功上传的消息。如果收到的不是 POST 请求,它会创建一个空的表单并渲染到模板中。

总的来说,这段代码实现了一个简单的文件上传功能,它将上传的文件保存到数据库中,并通过异步任务来处理这些文件,以避免阻塞主线程。

4. 进阶用法与注意事项

4.1. 进阶用法

4.1.1. 参数传递

在实际开发中,任务可能需要额外的参数来完成特定的工作。Celery和Django Q都支持向任务传递参数。例如,在Celery中,可以像这样调用任务:

add.delay(3, 5)

这将在后台执行add任务,并传递参数3和5给它。

4.1.2. 结果处理

有时候,我们需要获取任务执行的结果。Celery和Django Q都支持结果处理。在Celery中,可以通过AsyncResult对象来获取任务的结果:

result = add.delay(3, 5) print(result.get())

这将打印出任务执行的结果,即8。

4.2. 注意事项

4.2.1. 性能与资源消耗

在使用定时任务和后台任务队列时,务必注意其对系统性能和资源消耗的影响。特别是在部署到生产环境时,需要对任务的执行频率、并发量以及系统资源进行合理的调优和管理,以避免对整个应用程序的性能产生负面影响。

4.2.2. 错误处理与重试机制

在编写任务函数时,务必考虑到可能出现的异常情况,并提供相应的错误处理机制。同时,Celery和Django Q都提供了重试机制,可以在任务执行失败时自动重试,但需要根据实际情况配置重试策略,以避免任务陷入死循环或导致系统负载过重。

4.3. 安全性考虑

在实践定时任务和后台任务队列时,务必考虑安全性因素。特别是在处理敏感数据或执行重要操作时,需要采取一些额外的安全措施:

4.3.1. 认证与授权

确保只有授权的用户能够访问和执行任务。在Django中,可以使用装饰器或中间件来实现认证和授权机制,以保护任务的安全性。

4.3.2. 输入验证与过滤

对任务接收的输入进行验证和过滤是至关重要的。避免直接使用用户提供的数据作为任务参数,以防止恶意输入或注入攻击。

4.3.3. 日志与监控

及时记录任务的执行日志,并建立监控机制来监视任务的执行状态和性能表现。这样可以快速发现和应对潜在的安全问题或异常情况。

4.4. 扩展与定制

定时任务和后台任务队列通常是开发中的常见需求,但在特定场景下可能需要更多的定制和扩展功能。Celery和Django Q都提供了丰富的扩展机制和插件,可以根据项目的需求进行定制化开发,以满足更复杂的任务调度和处理需求。

4.5. 部署与维护

在将应用程序部署到生产环境之前,务必考虑定时任务和后台任务队列的部署和维护问题:

4.5.1. 部署策略

选择合适的部署方式和环境来运行定时任务和后台任务队列。可以考虑使用容器化技术(如Docker)来构建和部署任务执行环境,以提高部署的灵活性和可移植性。

4.5.2. 监控与报警

建立监控系统来监视定时任务和后台任务队列的运行状态和性能指标,并设置报警机制及时发现和处理异常情况,确保任务的可靠执行和系统的稳定运行。

4.5.3. 日志与审计

定时任务和后台任务队列的执行日志是排查问题和追踪任务执行情况的重要依据。确保及时记录任务执行日志,并建立审计机制对任务执行情况进行跟踪和分析,以便及时发现和解决问题。

4.6. 版本控制与文档

定时任务和后台任务队列的代码也需要进行版本控制和文档化,以便团队成员之间协作开发和维护。建议使用版本控制工具(如Git)管理任务代码,并编写清晰详细的文档来记录任务的设计和实现细节。

4.7. 测试与质量保障

定时任务和后台任务队列的稳定性和可靠性对于应用程序的正常运行至关重要。在开发过程中,务必进行充分的测试和质量保障工作,包括单元测试、集成测试和端到端测试等,以确保任务的正确性和可靠性。

总结

本文介绍了在Django中实践定时任务与后台任务队列的全过程,涵盖了基本概念、实现方法以及进阶用法与注意事项。在开发过程中,选择合适的工具和技术对于任务的调度和执行至关重要。Celery和Django Q作为两种常用的任务调度库,分别提供了强大的功能和灵活的扩展性,可以满足不同项目的需求。在实际应用中,需要根据项目特点和实际情况选择合适的工具和策略,并结合安全性考虑、部署与维护、测试与质量保障等方面进行综合考虑和管理。

总的来说,合理地利用定时任务与后台任务队列可以提高应用程序的功能性和灵活性,增强系统的稳定性和可靠性,为用户提供更好的使用体验。希望本文能够帮助读者更好地理解和应用定时任务与后台任务队列的相关知识,并在实践中取得成功。