您的位置:上海毫米网络优化公司 > 网站优化分享 >

相关推荐recommended

- Linux部署Sonarqube+Gogs+Jenkins(一)

- 【C语言】贪吃蛇【附源码】

- 新一代开源数据可视化平台 datart——技术架构与应用场景

- three.js 基础认识与简单应用

- 前端传输数组类型到后端(附代码)

- 掌握Go语言:Go语言类型转换,解锁高级用法,轻松驾驭复杂数据结构(3

- Java项目:基于Springboot框架实现的校园求职招聘系统(sp

- Node.js 连接 mysql 数据库(Navicat)超详细!!!

- 爬个数据这么吃力?别慌,代理IP轻松解决跨境电商技术瓶颈

- 二刷大数据(一)- Hadoop

- Cause: org.springframework.jdbc.Can

- 华为ensp中链路聚合两种(lacp-static)模式配置方法

- Navicat、Microsoft SQL Server Manage

- 爬虫解析——Xpath的安装及使用(五)

- Spring AI 来了,打造Java生态大模型应用开发新框架!

- 【MySQL】超详细MySQL常用日期格式转换函数、字符串函数、聚合函

- No ‘Access-Control-Allow-Origin‘ he

- python——Django 框架

- 解决正则表达式警告:DeprecationWarning: inval

- 已解决org.springframework.amqp.AmqpIOE

- 投springer的期刊时,遇到的一些latex模板使用问题

- MySQL 自增列解析(Auto

- 基于jsp+jdbc+mysql+html+css网上珠宝购物商城系统

- 解决,“该设备或资源(Web 代理)未设置为接受端口“7890”上的连

- 抖音六神最新算法

- 基于在线学习的分布式流量实时分析系统设计与实现

- 爬虫——python爬取京东商品用户评价

- 达梦兼容MySQL问题

- 2023年Java初中高架构后端真实面试题大全(有详细答案)--高频真

- 【AI云原生】Kubernetes容器环境下大模型训练和推理的关键技术

Python 爬虫之简单的爬虫(一)

作者:mmseoamin日期:2024-01-19

爬取网页上所有链接

文章目录

- 爬取网页上所有链接

- 前言

- 一、基本内容

- 二、代码编写

- 1.引入库

- 2.测试网页

- 3.请求网页

- 4.解析网页并保存

- 三、如何定义请求头?

- 总结

前言

最近也学了点爬虫的东西。今天就先给大家写一个简单的爬虫吧。循序渐进,慢慢来哈哈哈哈哈哈哈哈哈哈哈

一、基本内容

主要是以下几部分(下文基本会按照这个步骤来写):

- 导入需要的库

- 要测试的网页

- 生成代理,请求网页

- 请求成功,解析网页,找到并保存想要的东西

- 请求失败,返回相应状态码

二、代码编写

1.引入库

代码如下:

import requests from bs4 import BeautifulSoup

requests: 这是一个非常流行的 Python 库,用于发送 HTTP 请求。它可以方便地让我们获取网页内容、下载文件、提交表单等网络操作。

BeautifulSoup: 这是一个用于解析 HTML 和 XML 文档的 Python 库。它能够将复杂的HTML文档转换成树形结构,使得我们可以轻松地搜索、遍历和修改文档中的元素。

2.测试网页

代码如下:

# 目标网页地址 url = 'http://www.santostang.com/'

3.请求网页

代码如下:

# 定义请求头的浏览器代理,伪装成浏览器 headers = { 'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome' '/114.0.5735.289 Safari/537.36', 'host': 'www.santostang.com'} # 请求网页 response = requests.get(url, headers=headers) print(response.text)请求头header提供了关于请求、相应或其他发送实体的信息。总之一句话,这个很重要不能少。

不清楚这个请求头怎么搞的不要担心,下面我会另起一章节告诉大家怎么弄。

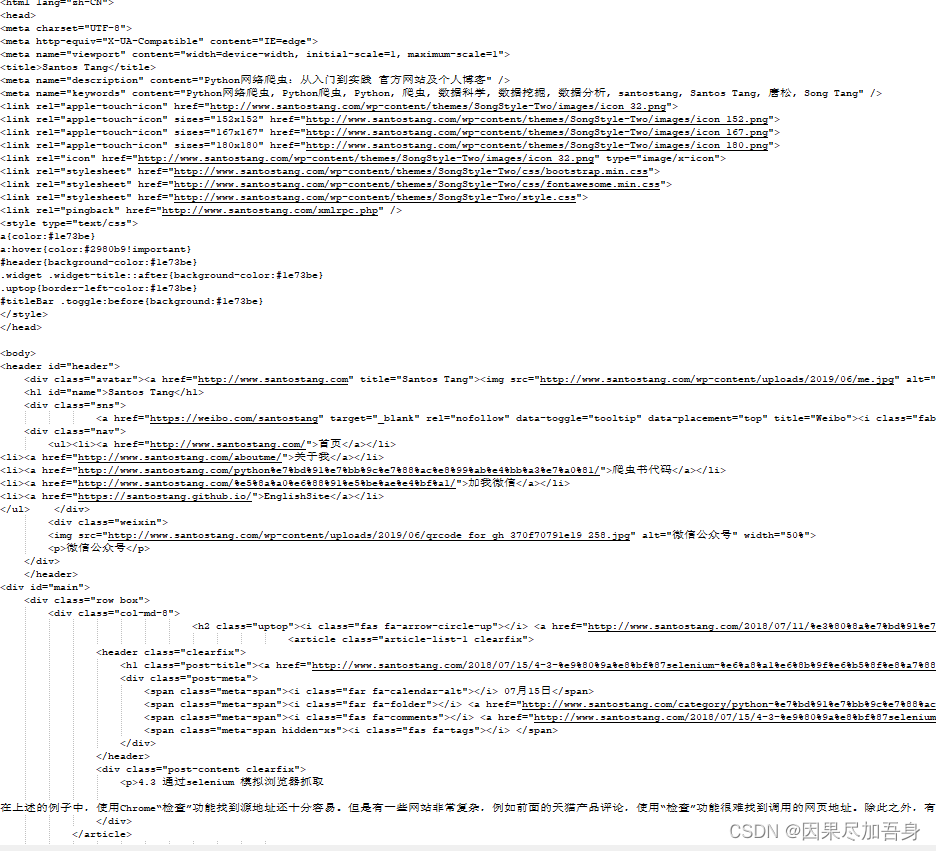

response.text 的内容如下图(下面会从这个里面检索获取我们想要的信息):

4.解析网页并保存

代码如下:

# 状态码为200,请求成功 if response.status_code == 200: # 打印状态码 print('Status Code: ', response.status_code) # 解析 HTML 文档 soup = BeautifulSoup(response.text, 'html.parser') # 找到所有的 ,和