您的位置:上海毫米网络优化公司 > 网站优化分享 >

相关推荐recommended

- SpringBoot 2.2.5 配置Logback打印日志,并自定义

- 网络编程探索系列之——广播原理剖析

- 【nginx实践连载-4】彻底卸载Nginx(Ubuntu)

- 投springer的期刊时,遇到的一些latex模板使用问题

- [架构之路-226]:信息系统建模 - 实体关系图、数据流图、数据字典

- 亮数据代理IP轻松解决爬虫数据采集痛点

- MySQL 故障诊断:MySQL 占用 CPU 过高问题定位及优化

- [已解决]ERROR 1290 (HY000): The MySQL

- GmSSL-3.1.1编译

- vue使用printJs实现前端打印,以及打印分页实现

- jenkins+gitlab配置

- Python Flask-Mail实现邮件发送

- SpringMVC基础篇(二)

- 解决Mysql异常【MySQLTransactionRollbackE

- SpringBoot使用WebSocket

- 使用 Python 连接到 PostgreSQL 数据库

- 【机器学习入门】集成学习之梯度提升算法

- SQL中 JOIN 的两种连接类型:内连接(自然连接、自连接、交叉连接

- 使用PySpider进行IP代理爬虫的技巧与实践

- Nginx源码下载与安装详解

- 【MyBatis Plus】初识 MyBatis Plus,在 Spr

- 如何选择适合的 MySQL ConnectorJ 版本

- Node Version Manager(nvm):轻松管理 Node

- 深度解析 Spring 源码:三级缓存机制探究

- 达梦兼容MySQL问题

- Python机器学习实战教程

- 【微服务】接口幂等性常用解决方案

- 个人博客系统|基于Springboot的个人博客系统设计与实现(源码+

- 头歌实践教学平台数据库原理与应用实训答案

- nuxt服务端渲染注意事项及nuxt内存溢出解决

pyspark笔记:over

作者:mmseoamin日期:2024-01-22

1 方法介绍

- 在 PySpark 中,over 函数是一个非常重要的概念,尤其是在使用窗口函数(例如 row_number, rank, dense_rank, lead, lag 等)时。

- over 函数允许你对一个数据集进行分组,然后在每个分组内应用窗口函数。

1.1 基本概念

-

窗口函数:

-

在 PySpark 中,窗口函数是用于执行聚合和其他复杂操作的函数,这些操作涉及到某种形式的分区和排序。

-

窗口函数不会导致行被折叠成单个输出行,不像标准的聚合函数那样。相反,它们会生成与输入行数相同的输出行数。

-

-

窗口规范(Window Specification):

-

在使用 over 函数时,你需要定义一个窗口规范。这个规范描述了窗口函数的作用范围,包括如何对数据进行分区(partitioning)、如何排序(ordering)以及是否有行或范围限制(frame specification)

1.2 over函数通常步骤

在 PySpark 中,使用 over 函数通常涉及以下步骤:

-

定义窗口规范:

-

使用 Window 类来定义分区和排序规则。

-

例如,Window.partitionBy("column1").orderBy("column2") 表示按 column1 进行分区,并在每个分区内按 column2 排序。

-

-

应用窗口函数:

- 窗口函数被应用于定义的窗口规范。

- 例如,F.row_number().over(windowSpec) 会在每个按 windowSpec 定义的窗口内对行进行编号。

- 在这里,F.row_number() 是窗口函数,而 .over(windowSpec) 则指定了这个函数应该如何在数据上操作。

-

2 举例

2.1 创建DataFrame

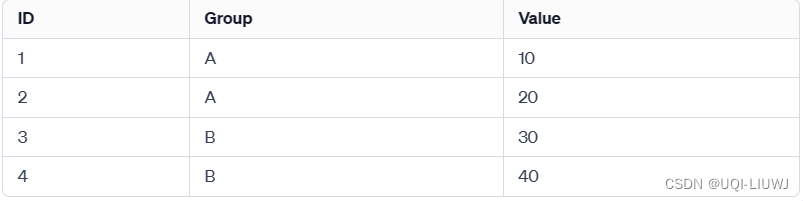

假设有一个如下的 DataFrame:

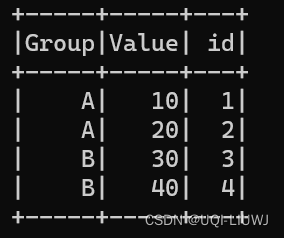

from pyspark.sql import Row data = [ Row(id=1, Group='A',Value=10), Row(id=2, Group='A',Value=20), Row(id=3, Group='B',Value=30), Row(id=4, Group='B',Value=40) ] df = spark.createDataFrame(data) df.show()

现在,如果你想在每个 Group 内部对 Value 进行排名,你可以使用 over 函数与 rank() 窗口函数结合来实现这一点:

2.2 定义窗口规范

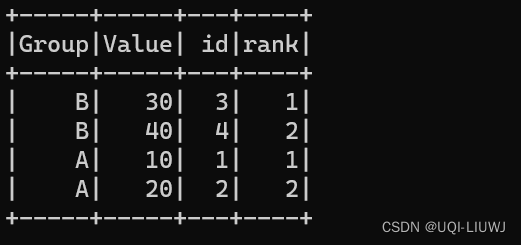

from pyspark.sql.window import Window import pyspark.sql.functions as F windowSpec = Window.partitionBy("Group").orderBy("Value") ''' partitionBy("Group") 表示数据将根据 Group 列的值进行分区。在每个分区内,数据行将独立于其他分区处理。 orderBy("Value") 指定了在每个分区内,数据将根据 Value 列的值进行排序。 注:此时windowSpec 本身并不知道它将被应用于哪个 DataFrame。它只是定义了一个窗口规范 '''2.3 应用窗口规范到 DataFrame

windowSpec 本身并不知道它将被应用于哪个 DataFrame。它只是定义了一个窗口规范。当在 df.withColumn 中使用 .over(windowSpec) 时,就指定了在 df 上应用这个窗口规范。

df.withColumn("rank", F.rank().over(windowSpec)).show() ''' df.withColumn———— 创建了 df 的一个新版本,其中包含了一个新列 "rank" F.rank().over(windowSpec) ————计算了一个窗口函数 rank,该函数在 windowSpec 定义的每个分区内为每行分配一个排名 '''

-

-